2. Sistemas espaciales de teledetección

Objetivos de la unidad

- Introducir a las y los estudiantes en los sistemas espaciales de teledetección, sus componentes y sus características principales.

- Facilitar la identificación y diferenciación de sensores y plataformas usados en teledetección.

- Capacitar a las y los estudiantes en la selección del sensor y la plataforma más conveniente según la intencionalidad del estudio o trabajo a realizar.

2.1. Tipos de sistemas espaciales en teledetección

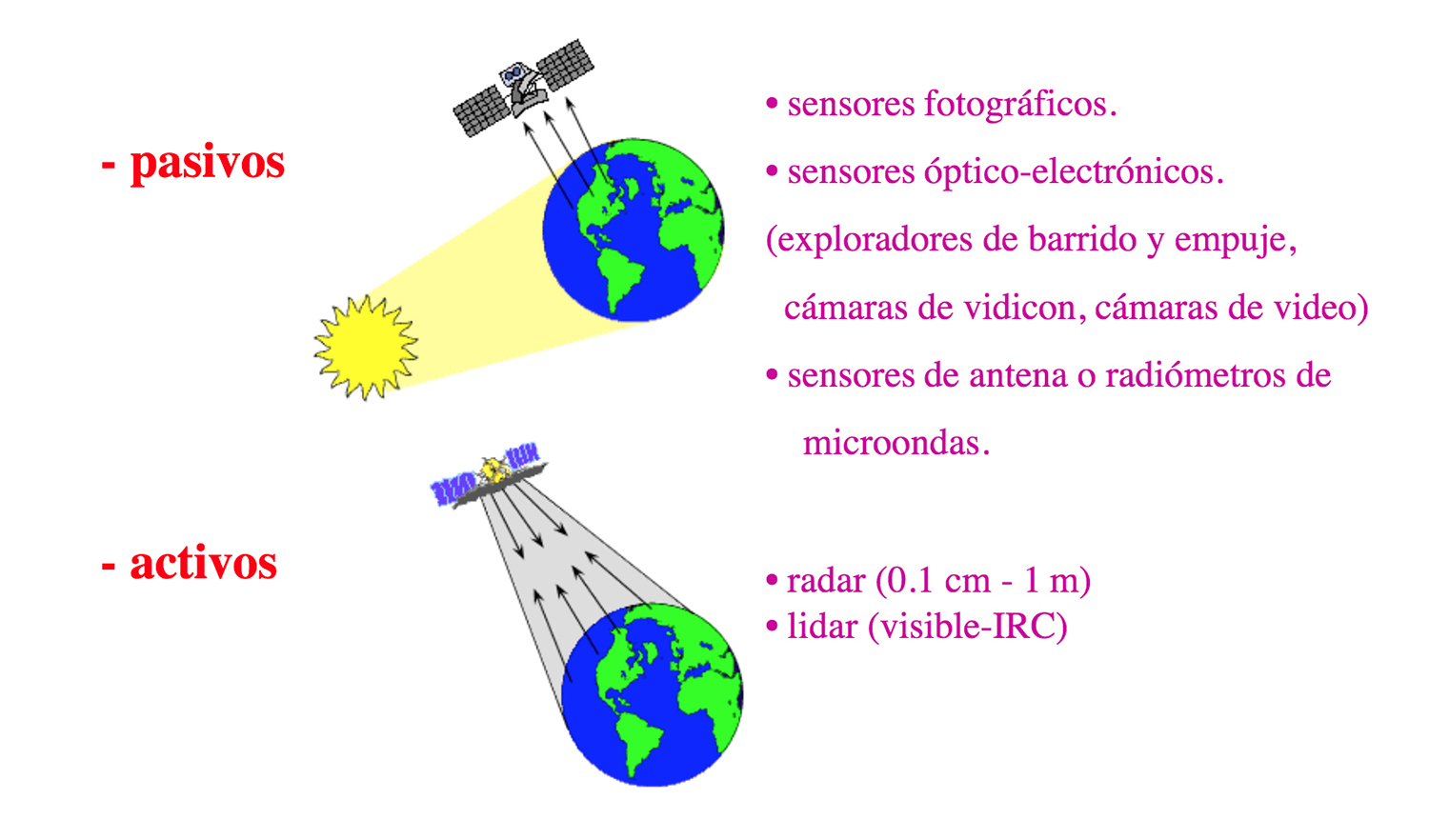

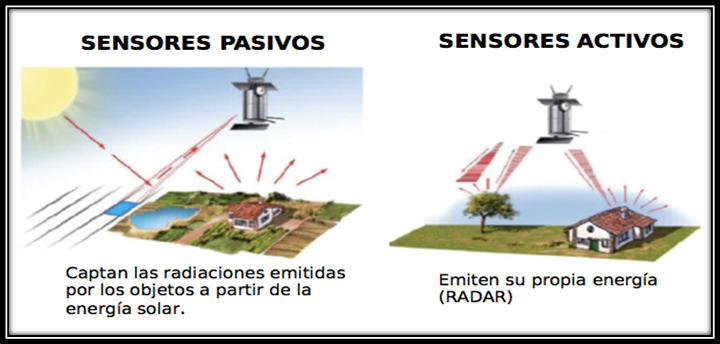

Como se señalaba en la unidad anterior, un sistema de teledetección necesita, al menos, tres componentes para funcionar: un foco de energía, la superficie terrestre y un sensor. Centrándonos en los sensores remotos vemos que se clasifican, según su procedimiento de recibir energía, en sensores activos o pasivosN (imagen 46). Según la forma de toma de datos pueden agruparse en generadores de imágenes o no generadores de imágenes. Los sensores pasivos, según su procedimiento para grabar la energía recibida, se agrupan en sensores fotográficos, óptico-electrónicos, de antena o radiómetros de microondas. El sensor activo más utilizado es el radar que opera en la región de las microondas. Por su parte, el lidar, otro sensor activo, es utilizado en el espectro visible y en el espectro infrarrojo cercano (Chuvieco, 1995: 89).

Recordemos que cuando la fuente de energía es el Sol, y el captador solo mide la radiación reflejada, se conoce como "teledetección pasiva". Si el mismo captador está provisto de una fuente emisora de energía que envía hacia el objetivo y mide el eco producido se denomina "teledetección activa".

Clasificación de sistemas sensores según la procedencia de la energía

Los sensores remotos, generalmente, necesitan de una plataforma donde integrarse para realizar el procedimiento de captar, registrar y transmitir la energía que reciben. Estas plataformas son los satélites (Landsat, Meteosat, NOAA, SPOT) o los aviones que los transportan.

En los apartados siguientes profundizaremos en las características de los sensores y las plataformas que los integran para conocer su rango de aplicaciones y, de este modo, saber cuál es el sensor que más nos conviene para realizar un tipo de análisis e interpretación específicos.

Chuvieco, E. (1995), Fundamentos de Teledetección espacial, segunda edición, Rialp, Madrid, pp. 97-116.

2.2. Formas y lugares desde donde teledetectar: sensores y plataformas

La década de 1960 marcó un punto y aparte en la tecnología existente de observación de la Tierra. Las plataformas satelitales comenzaron a reemplazar a las aéreas; y los sensores electrónicos multiespectrales, acoplados a computadoras, empezaron a sustituir a las fotográficas. Desde entonces, las posibilidades que ofrece la percepción remota avanzan de forma vertiginosa, convirtiéndose en una de las herramientas imprescindibles en el análisis y la toma de decisiones espaciales.

2.2.1. Sensores

Como ya se ha señalado, existen varias categorías amplias de tipos básicos de sistemas de sensores: pasivos-activos, generadores de imágenes-no generadores de imágenes, entre otros.

Reflejo de la fuente de energía sobre la superficie (radiación). Sensores pasivos y sensores activos

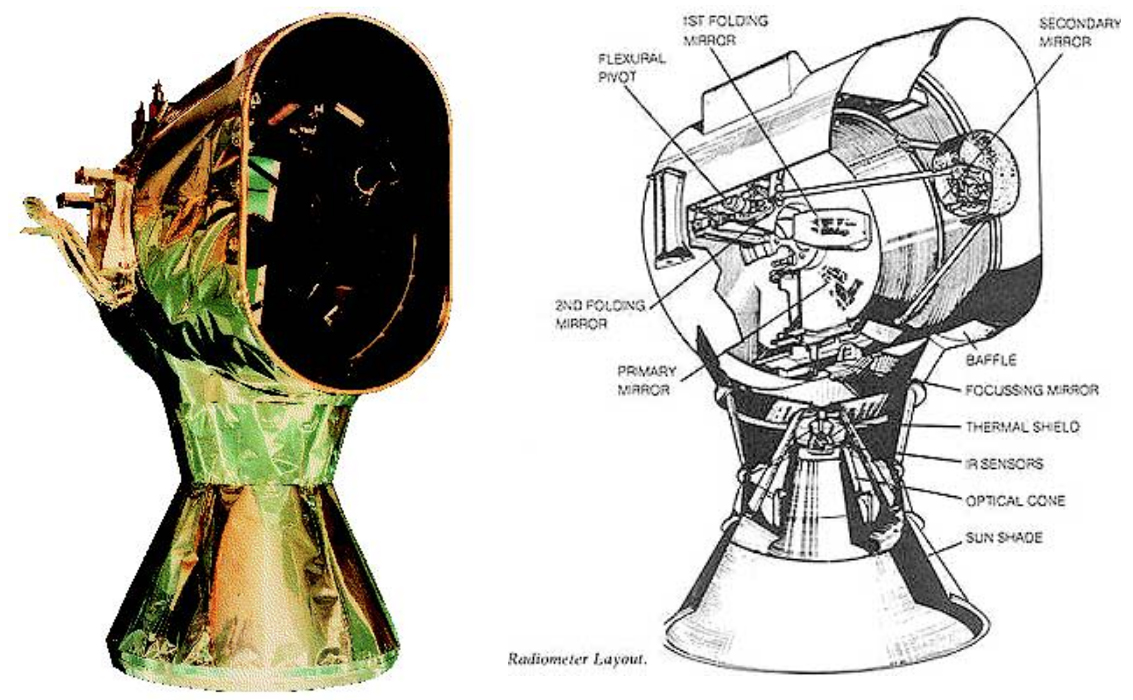

Profundizando en la clasificación pasivo-activo (imagen 47), observamos que los sensores pasivos (imagen 48) miden la luz reflejada o emitida de forma natural desde las superficies y los objetos. Los instrumentos simplemente observan y van a depender, principalmente, de la energía solar como la fuente de radiación final para iluminar superficies y objetos. Por el contrario, los sensores activos (sistemas de radar y lidar) primero emiten energía (suministrada por su propia fuente de energía) y luego miden el retorno de esa energía tras interactuar con una superficie. El uso de datos recopilados por sensores pasivos requiere, a menudo, mediciones precisas de la radiación solar que llega a la superficie en el momento en que se realizaron las observaciones. Esta información recopilada permite la corrección de “efectos atmosféricos” y da como resultado datos o imágenes que son los más representativos de las características reales de la superficie.

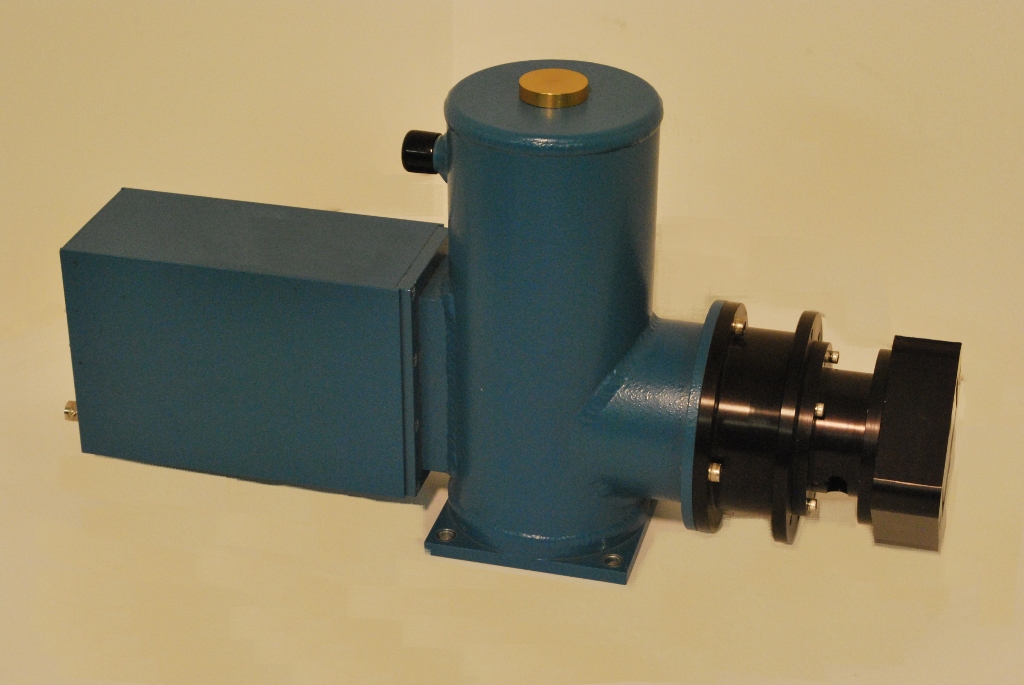

Ejemplo de captador pasivo: radiómetro del satélite Meteosat. Vista exterior (izquierda). Esquema del Radiómetro Meteosat (derecha)

Fuente: ESA/Eumetsat. <https://www.eumetsat.int/website/home/Satellites/>

Por otro lado, si comparamos los sensores generadores de imágenes con sensores no generadores de imágenes estamos poniendo el foco sobre la representación registrada de la radiación reflejada o emitida desde un área u objeto. La medición de la energía reflejada o emitida puede realizarse en forma de imagen o simplemente en forma de datos. Es decir, la información de los sensores de imágenes puede procesarse para producir una imagen de un área, dentro de la cual se resuelven visualmente partes más pequeñas de la vista completa del sensor. Los sensores no generadores de imagen (imagen 49), generalmente, son dispositivos de mano que registran un solo valor de respuesta, sin una resolución más fina que toda el área vista por el sensor; por lo tanto, no se puede crear una imagen a partir de esos datos. Estos valores únicos se pueden denominar como un tipo de datos “puntuales”; no obstante, algunas áreas pequeñas suelen estar involucradas en función de la resolución espacial del sensor.

Hyperspectral Non-Imaging Sensor CDP-3

Fuente: Solid State Scientific Corporation. <https://www.solidstatescientific.com/hyper-spectral-non-imaging.html>

Los datos de un sensor generador de imagen y de un sensor no generador de imagen tienen usos específicos. Los datos que no son imágenes proporcionan información para un área concreta (generalmente pequeña) o un tipo de cobertura de superficie. Esta información puede utilizarse para caracterizar la reflectancia de diversos materiales en un área mayor y para entender las interacciones de la energía electromagnética y los objetos. Por su parte, los datos de los sensores generadores de imagen brindan la oportunidad de observar las relaciones espaciales y las formas de los objetos; también permiten estimar los tamaños físicos según la resolución espacial y el muestreo de los datos.

Ejemplo de la aplicación de un sensor pasivo no generador de imágenes

Fuente: Ariel University. Disponible en: <https://www.youtube.com/watch?v=NRqxElCLJ3Q> [Consulta: 26 de agosto 2013].

Los datos de imagen son deseables cuando se necesita información espacial de la superficie. Las imágenes producidas a partir de datos de sensores remotos pueden ser analógicas (como una fotografíaN) o digitales (una matriz bidimensional o una cuadrícula de númerosN). Los datos digitales obtenidos deben ser calculados y analizados mediante el estudio de los valores en una computadora o deben ser procesados a fin de producir una imagen para su interpretación visual.

Dado que existen dos métodos para visualizar la energía electromagnética es necesario utilizar la palabra "foto" para aquellos casos en los cuales se registran las señales directamente en una película fotográfica y la palabra "imagen" para cualquier representación pictórica generada mediante un sensor. “Bajo esta convención todas las fotos son imágenes, pero no todas las imágenes son fotos” (Fallas, 2003: 23).

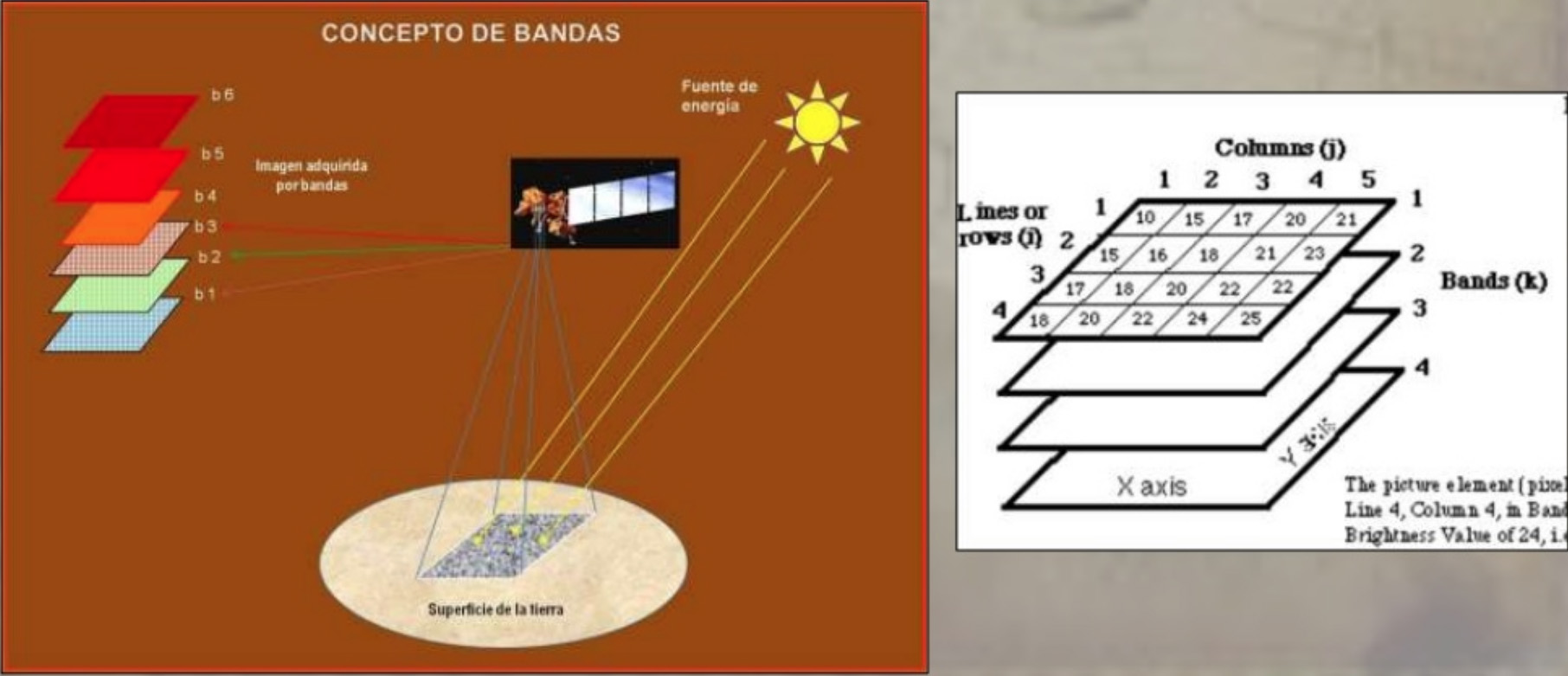

En una matriz bidimensional se representa una porción de espacio sobre la superficie terrestre con la unidad mínima de información conocida como "píxel" (picture element). Una imagen de satélite llega al usuario final como un conjunto de matrices, una por cada canal del sensor, en la que se muestran números del 0 al 255 (el 0 índica que no llega nada de radiación desde ese punto y el 255 señala que llega el valor más alto de radiación). Estos valores se denominan "niveles digitales" y es necesario transformarlos en algún tipo de variable física.

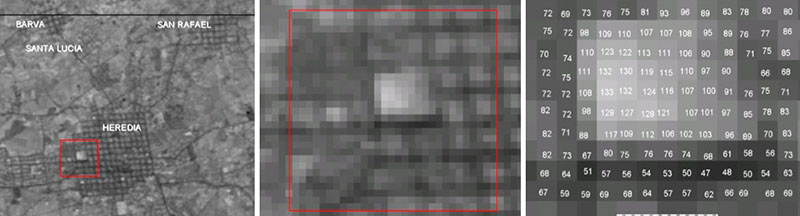

En relación con lo expuesto, en el siguiente ejemplo extraído del manual de teledetección espacial de Jorge Fallas (2003), la imagen 50 corresponde a una porción de una imagen del satélite SPOT del área central de Heredia, Costa Rica. En un primer acercamiento, la imagen parece reflejar una superficie continua de baja resolución de una foto aérea en blanco y negro. No obstante, al realizar una ampliación de una parte del área del cuadrado (imagen 51) puede observarse que el patrón se pierde y que ya no es posible identificar el trazado del área urbana. Si se continúa ampliando la imagen (imagen 52), pueden verse cada uno de los píxeles o elementos pictóricos. El sensor registra así “para cada píxel la energía que refleja la superficie terrestre y, posteriormente, es transformada en un valor digital (VD) mediante un instrumento denominado convertidor analógico-digital” (Fallas, 2003: 24-25).

Imagen 50. Porción de una imagen del satélite SPOT, banda 3 (infrarroja). Sector de Heredia.

Imagen 51. Vista del área ampliada en el recuadro de color rojo de la figura 50. El patrón del trazado urbano es ahora indistinguible.

Imagen 52. Ampliación del sector central del área indicada en la figura 51.

Fuente: Fallas (2003).

En la mayor parte de los casos, la interpretación de imágenes implica la utilización de técnicas tanto visuales como digitales. Estas técnicas emplean una serie de características de imagen (tono y color, textura, forma, tamaño, patrones y asociaciones de objetos) que facilitan el proceso de análisis del ojo y el cerebro humano. Asimismo, las computadoras facilitan el análisis de los elementos espectrales de una imagen, como el tono y el color (Fallas, 2003: 25).

Labrador García, M., Évora Brondo, J. y Arbelo Pérez, M. (2012), Satélites de teledetección para la gestión del territorio. Proyecto Satelmac, Consejería de Agricultura, Ganadería, Pesca y Aguas del Gobierno de Canarias, Las Palmas de Gran Canarias, pp. 21-58.

Reflexione y conteste las siguientes preguntas:

- Una cámara tiene una longitud focal de 150 mm y la altitud del avión sobre el nivel del suelo es de 7800 m. ¿Cuál es la escala de la fotografía?

Se utilizó una cámara con una distancia focal de 310 mm para tomar fotografías desde 3500 m sobre el nivel del mar principal.

- Encuentre la escala en la ubicación del punto A (800 m sobre el nivel medio del mar) y el punto B (0 m sobre el nivel medio del mar).

- Imagine que una pista de 400 m está ubicada en A y B. ¿Cuál sería la diferencia de tamaño en centímetros en la fotografía?

Sensores pasivos (sistemas fotográficos, radiómetros multi e hiperespectrales, espectrómetros de imagen)

Dentro de los sensores pasivos encontramos los sensores fotográficos, óptico-electrónicos –que combinan una óptica similar a la fotográfica y un sistema de detección electrónica (detectores de barrido y empuje)–, espectrómetros de imagen y de antena (radiómetros de microondas).

Sensores fotográficos. El sensor más común es la cámara fotográfica. A lo largo de la historia de la teledetección, muchos de sus avances han estado directamente relacionados con el desarrollo de sistemas fotográficos. Las cámaras son similares en diseño al ojo humano. Ambos tienen una lente en un extremo de una cámara cerrada y un material sensible a la luz (película en una cámara, retina en un ojo humano) en el otro. En ambos se utiliza un iris para controlar la cantidad de luz que puede golpear la película/retina. Hay tres elementos básicos de los sistemas fotográficos: óptica, película y filtros. La óptica se refiere a las lentes y la geometría de la recuperación de luz en una cámara. Las lentes de una cámara son responsables de enfocar un objeto. En una cámara, se coloca un obturador entre la lente y la película para controlar cuánto tiempo puede la luz golpear la película. Es posible colocar filtros delante de una lente para restringir la longitud de onda de la luz que golpea la película. Antes de que la luz reflejada de un objeto golpee la película, debe pasar a través de una o más lentes. Para minimizar las distorsiones asociadas con el uso de lentes individuales, la mayoría de las lentes de cámara están compuestas de múltiples lentes que funcionan en conjunto para formar una imagen en la película (Chuvieco, 1995: 98).

La cantidad de detalle de la imagen que se puede grabar en la película está directamente relacionada con la distancia entre la lente y la película, esto se conoce como distancia focal. A medida que aumenta la distancia focal, aumenta el detalle que se puede ver en la película. El aumento de la distancia focal se denomina comúnmente zoom sobre un objeto. La película fotográfica en una cámara se utiliza para grabar la imagen que pasa a través de la lente y está compuesta de una base compacta recubierta con una capa sensible a la luz conocida como emulsión. Durante el breve periodo que un obturador está abierto, la luz golpea la película y deja una imagen latente en la emulsión. Esta imagen puede hacerse visible mediante el proceso de revelado e impresión. Las emulsiones están hechas de materiales sensibles a regiones particulares del espectro electromagnético (CCPO, 2003; NASA, 2018).

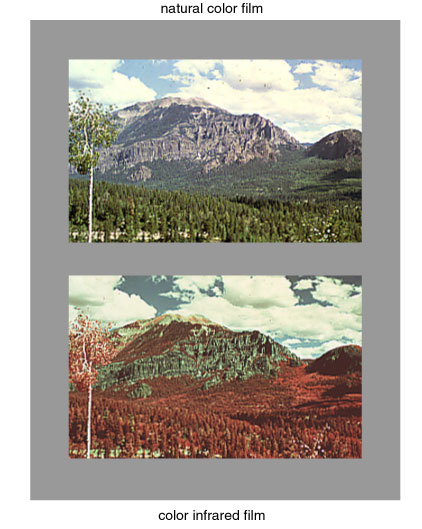

Algunas películas solo son sensibles a la luz visible, mientras que otras son sensibles a la luz del infrarrojo cercano. En la película de color, la emulsión se compone de tres capas, cada una de ellas sensible a diferentes longitudes de onda de la luz, normalmente azul, verde y roja. Con una película en blanco y negro, la emulsión es sensible a un amplio espectro de luz. Las emulsiones de película generalmente se limitan a registrar longitudes de onda entre 0.4 y 0.9 um.

La imagen 53 muestra dos fotografías, una de ellas (parte superior) está expuesta utilizando una película de color natural, la otra (parte inferior), está utilizando una de color infrarrojo (un tipo diferente de película).

Exposición usando dos tipos diferente de película

La velocidad de la película es otra cualidad de las emulsiones que es importante en la fotografía aérea. Refiere a la cantidad de luz que se necesita para exponer la emulsión. La película rápida requiere menos luz que la película lenta para grabar la misma imagen. En este sentido, si la plataforma de la cámara se está moviendo, es deseable usar una película de alta velocidad para reducir los efectos de desenfoque por el desplazamiento de la cámara. Desafortunadamente, existe un equilibrio entre la velocidad de la película y la calidad de la imagen: cuanto más rápida es la primera más granulada (de peor calidad) es la imagen. Debido a esto es necesario elegir una velocidadN que cumpla con los requisitos del usuario final (CCPO, 2003; NASA, 2018).

Algunos montajes de cámara sofisticados tienen un compensador de movimiento de imagen que reduce el efecto de desenfoque de la plataforma cuando se desplaza, lo que potencialmente permite el uso de películas más lentas.

En muchas aplicaciones de detección remota es importante restringir la luz que entra a la cámara mediante el uso de filtros. Los filtros de color funcionan absorbiendo un rango de longitudes de onda mientras permiten que otras longitudes de onda los atraviesen. Otro tipo, conocido como filtro de color neutro, no altera la composición espectral de la luz, sino que reduce la cantidad de luz de todas las longitudes de onda que pasan. Quizás el filtro de color más común es el filtro anti-Haze, transparente o amarillo, que absorbe las longitudes de onda azules y ultravioletas más cortas que se dispersan sustancialmente por las partículas en la atmósfera. Otro de los usados con frecuencia para monitorear la vegetación es un filtro infrarrojo, que absorbe la luz visible y solo permite que la luz infrarroja pase a través de él (CCPO, 2003; NASA, 2018).

La fotografía aérea es una de las formas más antiguas de teledetección remota y todavía se usa ampliamente en la actualidad. Por lo general, es la opción más utilizada si se necesitan grandes detalles espaciales.

La fotografía se puede usar para identificar especies que tengan (según la forma de árboles individuales) y medir su altura empleando técnicas fotográficas especiales. Debido a los detalles que se pueden distinguir en una fotografía, la fotografía aérea se utiliza ampliamente para mapear las clases de vegetación. Asimismo, es útil como herramienta de reconocimiento para proporcionar información general sobre un área en particular. Por ejemplo, en el caso de haber detectado un brote de una enfermedad que está matando a un determinado árbol o especie agrícola, la fotografía aérea que usa una película infrarroja (para localizar árboles que están bajo estrés) puede monitorear las áreas para detectar signos en los individuos y conocer la extensión de la enfermedad.

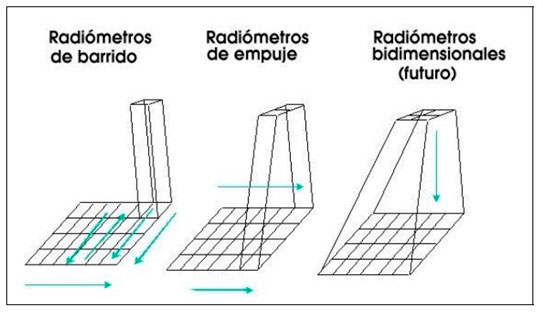

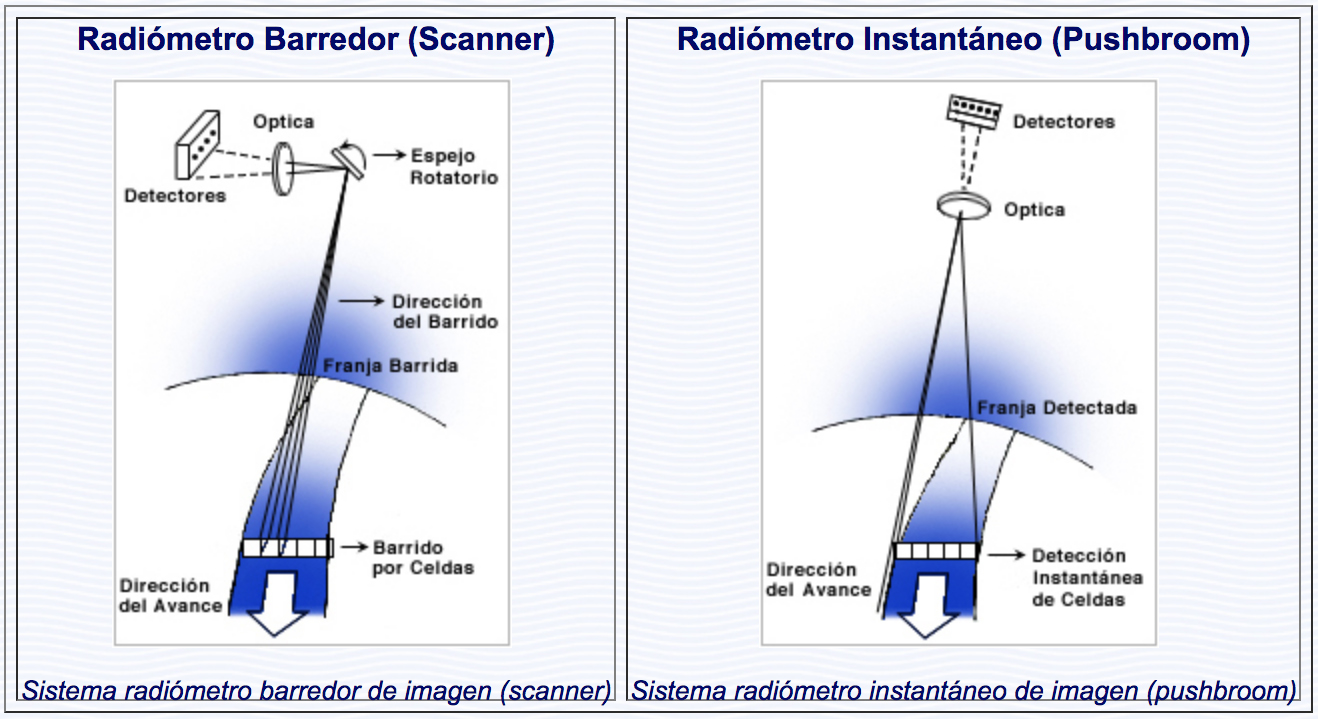

En un sistema óptico-electrónico, la radiación recibida por los componentes ópticos se descompone en varias longitudes de onda. Cada una de ellas se envía a un conjunto de detectores sensibles a esa región del espectro, los que la amplifican y la convierten, primero, en señal eléctrica y, finalmente, en un valor numérico conocido como nivel digital (ND). Existen dos grandes tipos de sistemas óptico-electrónicos: los radiómetros de barrido y los radiómetros de empuje (imagen 54).

Radiómetro de barrido y radiómetros de empuje

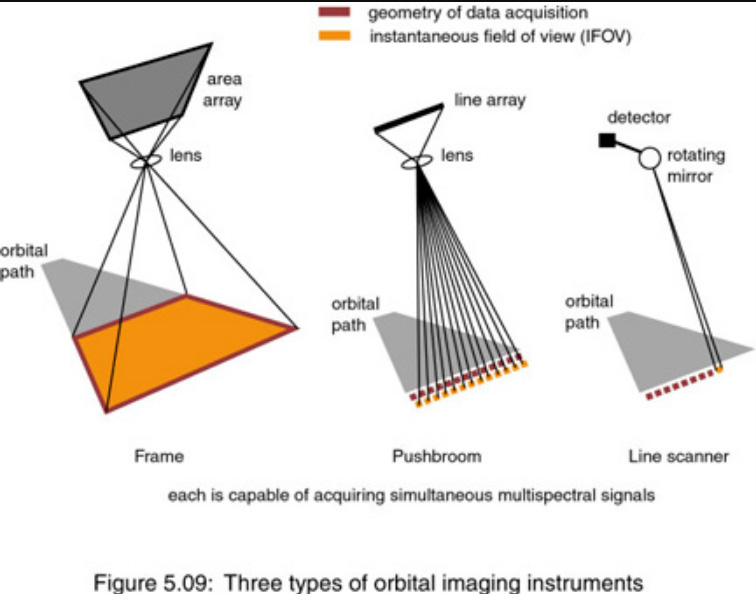

Los radiómetros de barrido son los más habituales en teledetección. Disponen de un espejo móvil que oscila perpendicularmente a la dirección de la trayectoria y que permite explorar una franja de terreno a ambos lados de esta. Cada movimiento del espejo envía información de una franja distinta al conjunto de sensores. Por su parte, los radiómetros de empuje eliminan el espejo oscilante al disponer de una cadena con un gran número de detectores con los que se cubre todo el campo visual del sensor. Esto permite aumentar la resolución espacial y reducir los errores geométricos, ya que se ha eliminado la parte móvil de los detectores de barrido. No obstante, la calibración de todos los sensores al mismo tiempo para que se comporten de forma homogénea es una tarea excesivamente compleja. Estos problemas son especialmente graves para captar el espectro infrarrojo. Sin embargo, los avances tecnológicos están cada vez más cerca de fabricar sensores capaces de captar toda la imagen al mismo tiempo, como una matriz bidimensional, para poder eliminar los errores geométricos (imagen 55) (CCPO, 2003; Chuvieco, 1995; NASA, 2018).

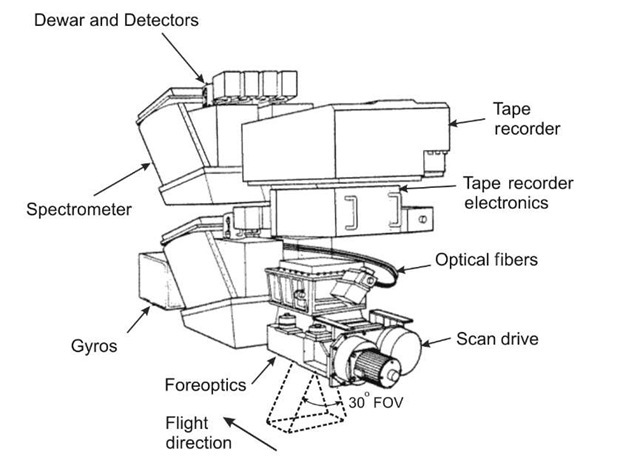

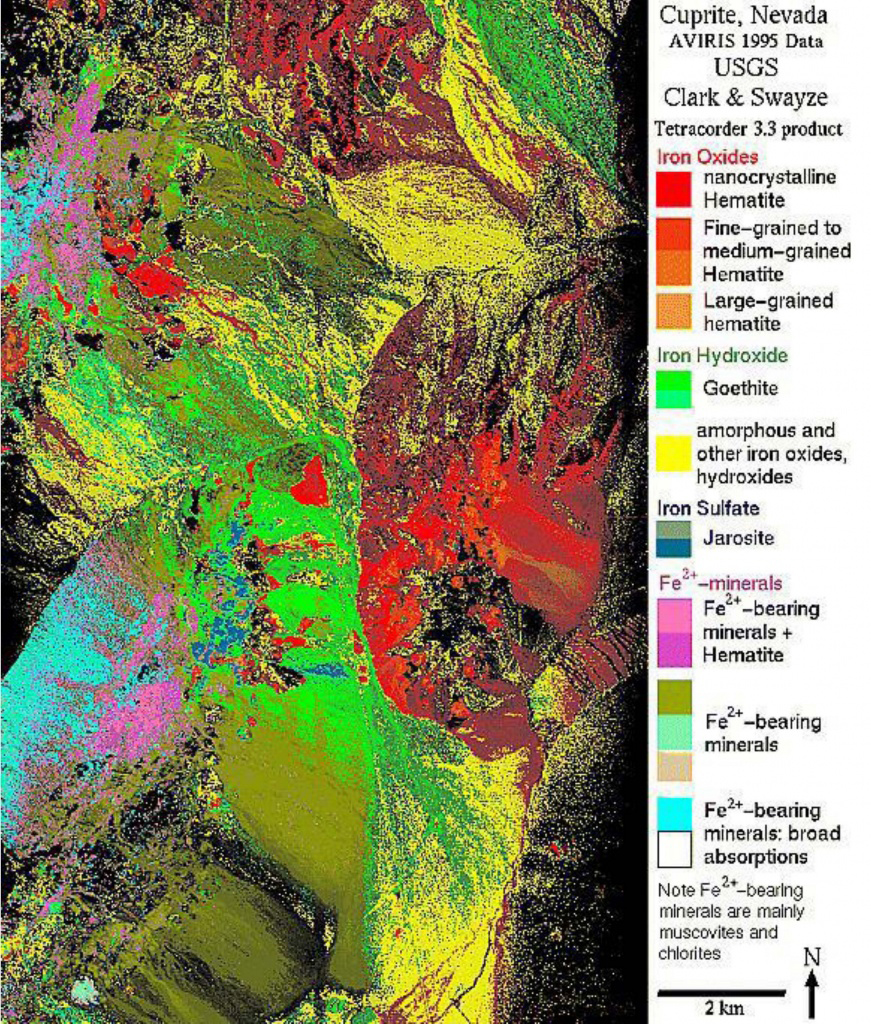

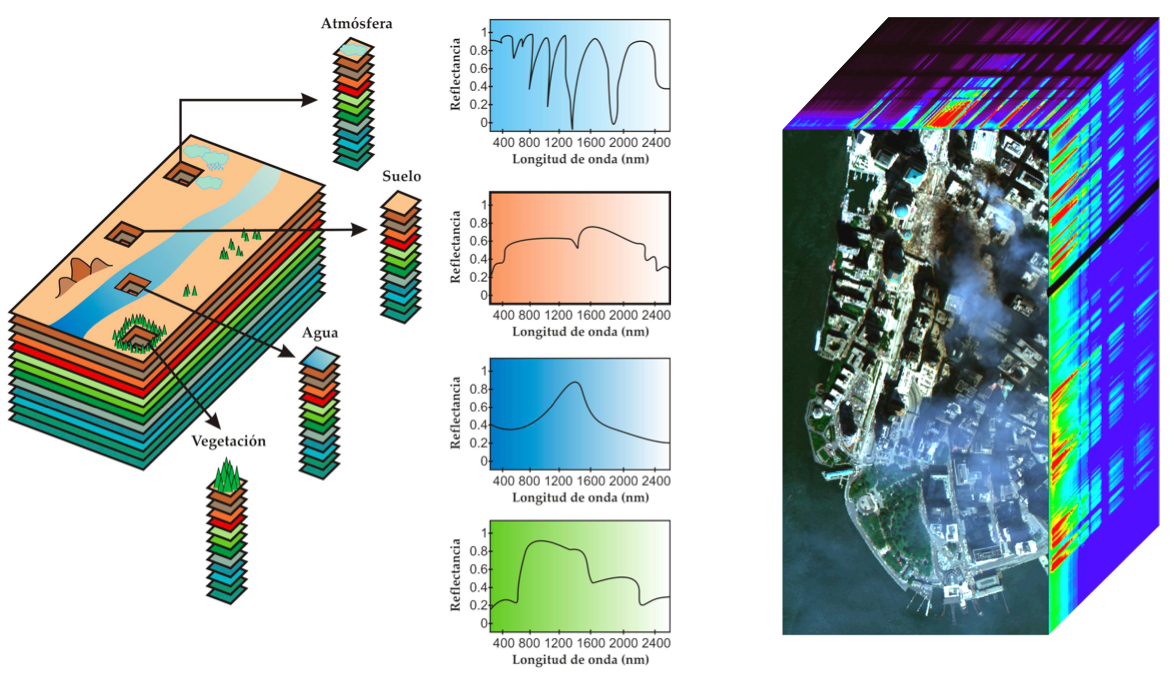

Los espectrómetros de imagen conforman una nueva generación de instrumentos cuyo objetivo es obtener imágenes en un gran número de bandas espectrales (entre 64 y 200 bandas a intervalos de 10-20 nm) obteniendo así un espectro casi continuo de radiación. Para obtener imágenes de alta resolución espacial se utilizan espectrómetros aerotransportados como el sensor Aviris (Airbone Visible/Infra-Red Imaging Spectrometer) con 210 bandas entre 0.4 y 2.4 µm y 20 m de resolución espacial (imágenes 56 y 57) (CCPO, 2003; Pérez Martínez, 2011).

Esquema del sensor Aviris

Imagen Aviris sobre Cuprite, Nevada

Fuente: NASA/JPL.

Los radiómetros electro-ópticos son instrumentos diseñados para medir la intensidad de la radiación electromagnética en un conjunto de bandas de ondas que van desde la longitud de onda ultravioleta hasta la de microondas. Se denominan sensores electro-ópticos porque miden la energía electromagnética utilizando técnicas ópticas y detectores electrónicos (Pérez Martínez, 2011). Aunque solo son capaces de registrar un único valor de datos para su área de visualización, si se insertan en un dispositivo de escáner pueden producir imágenes. Los radiómetros son similares en diseño a una cámara que conserva una abertura para que entre la luz y tiene lentes y espejos, pero en lugar de una película tiene un detector electrónico para registrar la intensidad de la energía electromagnética. A medida que la energía llega al detector, una señal proporcional a la radiación entrante se procesa hacia una salida digital o analógica que se puede grabar. Se han ideado detectores para radiómetros destinados a medir longitudes de onda de 0.4 a 14 um. Aunque algunos radiómetros pueden detectar este rango completo de longitudes de onda, la mayoría solo mide las bandas de onda seleccionadas dentro de este rango (CCPO, 2003; NASA, 2018; Pérez Martínez, 2011).

Los radiómetros que miden más de una banda de onda se llaman radiómetros multiespectrales. Para este tipo de radiómetro, la luz debe estar separada en bandas de ondas discretas para que se puedan tomar múltiples lecturas de banda de ondas o multicanal. Esta separación se puede hacer usando filtros, prismas u otras técnicas sofisticadas. Los radiómetros sin imágenes se utilizan comúnmente como herramientas de investigación para comprender mejor cómo la luz interactúa con los objetos, para la caracterización espectral de una variedad de superficies y para las mediciones atmosféricas. Otro uso común es medir la cantidad y calidad de la energía solar. Estas mediciones se pueden utilizar a su vez para corregir otras mediciones de imagen y sin imagen para los efectos atmosféricos (Chuvieco, 1995; Pérez Martínez, 2011).

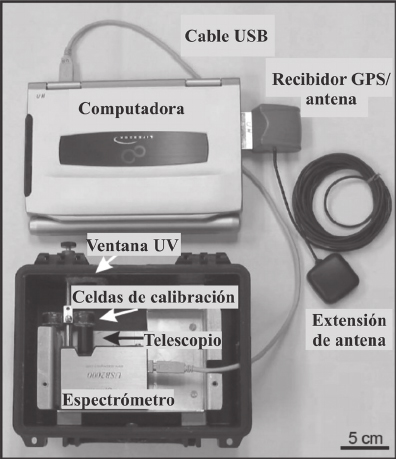

Los radiómetros de microondas (espectómetros de antena) se basan en un tipo de radiómetro que detecta las longitudes de onda en la región de microondas del espectro. Los componentes de un radiómetro de microondas son una antena, un receptor y un dispositivo de grabación (imagen 58). La energía de microondas emitida desde la superficie de la Tierra es recogida por una antena, convertida en una señal por un receptor y registrada en un grabador. En este tipo de sistemas, la resolución espacial es inversamente proporcional al diámetro de la antena y directamente proporcional a la longitud de onda. Asimismo, se necesitan tamaños de píxel lo suficientemente grandes para recoger una señal de radiación amplia. La resolución espacial de los radiómetros de microondas es pequeña y solo pueden aplicarse en estudios globales (CCPO, 2003; Pérez Martínez, 2011).

Componentes de un FLYSPEC (espectrómetro USB2000) Fuente: Rodríguez y Nadeau (2015)

Fuente: National Snow and Ice Data Center.

Las características de la energía electromagnética medida por los radiómetros de microondas son la polaridad, la longitud de onda y la intensidad. Estas propiedades proporcionan información útil sobre la estructura y composición de un objeto. La mayoría de las aplicaciones de los radiómetros de microondas pasivos se encuentran en los campos de la investigación atmosférica y oceanográfica (imagen 58). También ha demostrado ser una herramienta eficaz para medir la humedad del suelo, un parámetro importante en el estudio de la vegetación (CCPO, 2003; Pérez Martínez, 2011).

Finalmente, existen los sistemas de imagen térmica, infrarroja y visible. Es posible crear un sensor que pueda adquirir una imagen 2D de un área combinando varios detectores o radiómetros en conjuntos de detectores. Hay tres diseños básicos para los sensores de imagen: frame, pushbroom y line scanner (imagen 59).

Tres tipos de instrumentos de imágenes orbitales

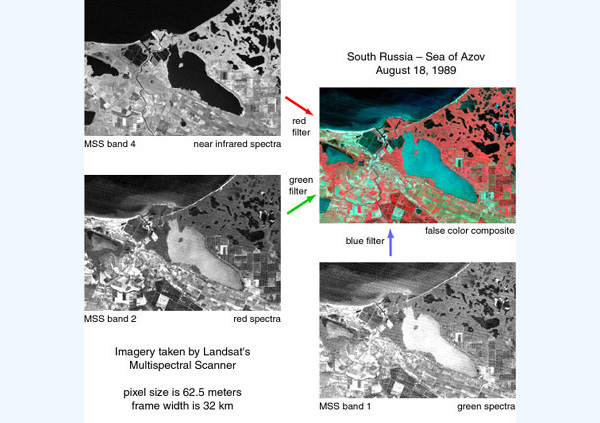

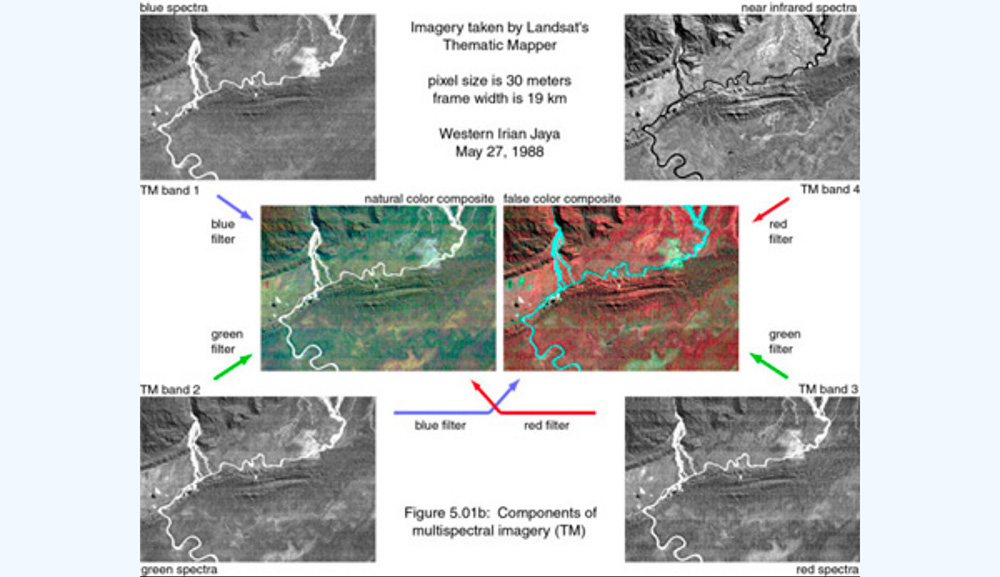

Esta categoría de sensores (sistemas de imágenes pasivas visibles, infrarrojas y térmicas) contiene numerosos instrumentos que se han implementado en una amplia variedad de plataformas y se han utilizado para muchas aplicaciones. La mayoría de los sistemas de imágenes modernos son multiespectrales (adquisición de datos para más de un área espectral limitada). La grabación de cada muestreo espectral discreto se conoce como una banda o canal de imagen. Usando técnicas de procesamiento de imágenes, se pueden combinar múltiples (generalmente tres) bandas seleccionadas de una base de datos de imágenes multiespectrales para crear una imagen compuesta de un solo color (imágenes 60 y 61).

Componentes de una imagen multiespectral. Sensor Landsat-MSS (Multispectral scanner)

Los sensores pasivos son el tipo de sensor más común para la detección remota relacionada con la vegetación. Esto no solo se debe a que los sistemas de sensores pasivos, generalmente, tienen un diseño más simple (construido solo para recibir energía), sino también porque algunas partes del espectro solar proporcionan información muy útil para monitorear las propiedades de la planta y el dosel forestal.

Una limitación importante de los sistemas pasivos es que, en la mayoría de los casos, requieren luz solar para poder adquirir datos válidos y útiles. En consecuencia, el despliegue o la adquisición de datos por sensores pasivos depende en gran medida de la iluminación (hora del día, hora del año, latitud) y las condiciones climáticas, ya que la cubierta de nubes puede interferir con la trayectoria de la radiación del Sol a la superficie y luego al sensor. Las señales detectadas por los sensores pasivos se pueden alterar en gran medida debido a los efectos atmosféricos, especialmente en las longitudes de onda más cortas del espectro solar que están muy dispersas por la atmósfera. Estos efectos se pueden minimizar (pero no eliminar) mediante la recopilación de datos solo en condiciones atmosféricas muy claras y secas. En la actualidad, existen sofisticadas rutinas de corrección atmosférica para eliminar los efectos atmosféricos de los datos adquiridos por los sensores pasivos (CCPO, 2003; Pérez Martínez, 2011).

Sensores activos (radar, lidar)

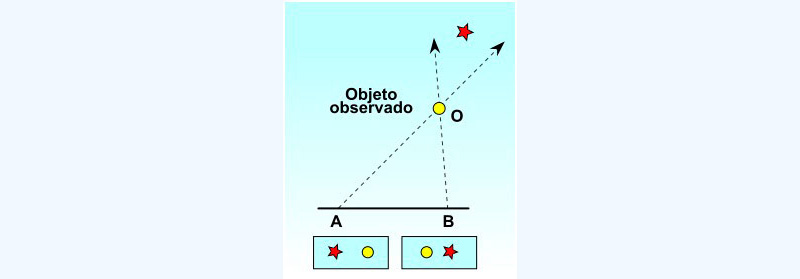

La mayoría de los sensores activos operan en la porción de microondas del espectro electromagnético, lo que les permite superar las condiciones atmosféricas la mayor parte del tiempo. Estos sensores poseen una técnica activa que “ve” el objetivo desde cualquier extremo de una línea base de longitud conocida. El cambio en la dirección de vista aparente (paralaje)N está relacionado con la distancia absoluta entre el instrumento y el objetivo (imagen 62). Existen dos tipos principales de sensores activos: radar y lidar.

Dos observadores/as verán en posiciones distintas, respecto al fondo, como consecuencia de la (o el) paralaje.

“La (o el) paralaje es la variación aparente de la posición de un objeto, especialmente un astro, al cambiar la posición del observador” (RAE).

El radar es un sensor de alcance y detección de radio activo que proporciona su propia fuente de energía electromagnética. De este modo, no requiere iluminación solar de las superficies o de unas condiciones climáticas perfectas para recopilar datos útiles. Por ello, puede implementarse por la noche o en condiciones de bruma, nubes o lluvia ligera (dependiendo de la longitud de onda del sistema).

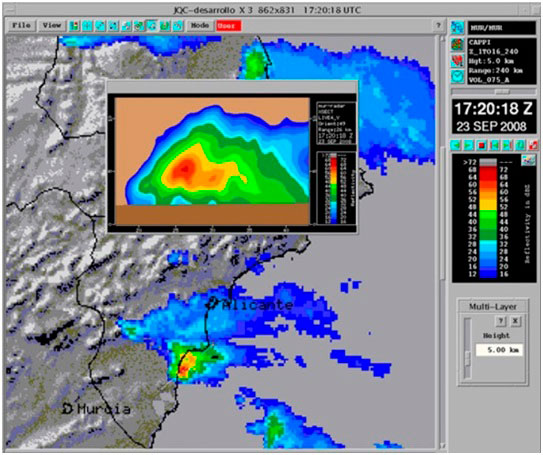

Un sensor de radar activo, ya sea aéreo o espacial, emite radiación de microondas en una serie de pulsos desde una antena. Cuando la energía alcanza el objetivo, parte de la energía se refleja, de vuelta, hacia el sensor (imagen 63). Esta radiación de microondas retrodispersada se puede detectar, medir y cronometrar. El tiempo requerido para que la energía viaje al objetivo y regrese al sensor determina la distancia o el alcance del objetivo. Al registrar el rango y la magnitud de la energía reflejada desde todos los objetivos a medida que el sistema pasa, se puede producir una imagen bidimensional (imagen 64) de la superficie (CCPO, 2003; NASA, 2018).

Los sistemas de radar (detección de radio y alcance) utilizan microondas (longitudes de onda que van desde 1 mm hasta 1 m). Los impulsos de microondas se transmiten a un objetivo o superficie, y se registran el tiempo y la intensidad de la señal de retorno.

Instalaciones de la estación radar situada en el Pico Mijas (Málaga, España)

Fuente: Agencia Estatal de Meteorología (Aemet), España.

Observación de una tormenta en Elche, España, el 23 de septiembre de 2008 con el nuevo sistema de observación radar

Fuente: Agencia Estatal de Meteorología (Aemet), España.

Las características de transmisión del radar dependen de la longitud de onda y la polarización del pulso de energía. Las bandas de longitud de onda comunes utilizadas en la transmisión de impulsos son la banda KN (11-16.7 mm), la banda X (24-37.5 mm) y la banda L (150-300 mm). Distinta de la longitud de onda es la polarización de la energía transmitida. Los pulsos se pueden transmitir o recibir en un plano de polarización H (horizontal) o V (vertical). Los factores que determinan la intensidad de una señal de retorno de radar son complejos y variados; sin embargo, los más importantes son los referidos a las propiedades geométricas y eléctricas de la superficie u objeto que refleja la señal. El radar detecta información sobre la estructura y composición de los objetos y superficies. Se ha utilizado en varios campos, incluidos los estudios de geología, nieve y hielo, oceanografía, agricultura y vegetación (CCPO, 2003; NASA, 2018).

El uso de códigos de letras para designar el rango de longitud de onda para varios sistemas de radar tiene su origen en el desarrollo del radar en Estados Unidos durante la Segunda Guerra Mundial. Las letras se asignaron arbitrariamente para garantizar la seguridad militar; sin embargo, su uso ha persistido hasta la actualidad (NASA, 2018).

Pérez Martínez, F. (2011), Sensores electromagnéticos. Los “Sentidos” de los Sistemas para Defensa y Seguridad, Madrid, Cuadernos Cátedra Isdefe-UPM. Disponible en <https://catedraisdefe.etsit.upm.es/wp-content/uploads/2011/11/PDF-cuaderno-N%C2%BA-9.pdf>, pp.66-104.

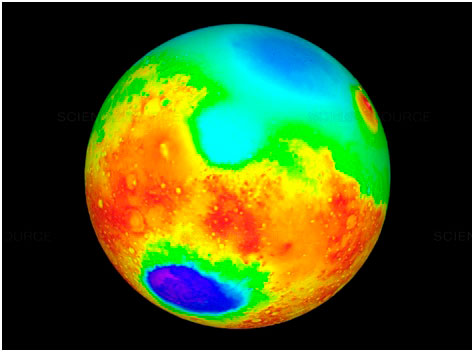

Los sistemas lidar (detección y alcance de luz) utilizan la luz láser como fuente de iluminación (amplificación de luz por emisión de radiación estimulada), un radar para transmitir un pulso de luz y un receptor con detectores sensibles para medir la luz retrodispersada o reflejada. El láser emite un breve pulso de luz y un detector recibe la energía de la luz (fotones) después de que un objeto o superficie la haya reflejado, absorbido y remitido. Los sistemas lidar emiten pulsos a longitudes de onda específicas y estrechas que dependen del tipo de transmisor láser utilizado. El rango de longitudes de onda posible es de aproximadamente 0.3 a 1.5 um, que cubre el espectro espectral ultravioleta a través del infrarrojo cercano. Los sistemas lidar más simples miden el tiempo de viaje de ida y vuelta de un pulso láser, que está directamente relacionado con la distancia entre el sensor y el objetivo. La distancia al objeto se determina al registrar el tiempo entre los pulsos transmitidos y retrodispersados y al utilizar la velocidad de la luz para calcular la distancia recorrida. Los lidar de medición de distancia básica a menudo se conocen como telémetros o como altímetros láser si se despliegan en una aeronave o nave espacial. Estos sistemas suelen medir la elevación, la pendiente y la rugosidad de las superficies de tierra, hielo o agua (CCPO, 2003; NASA, 2018).

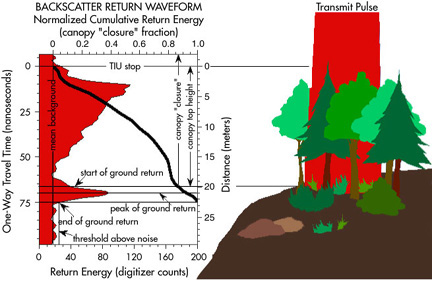

Un altímetro láser es un instrumento que emplea un lidar para medir la altura de la plataforma (nave espacial o avión) respecto de la superficie (imagen 65). Esta altura de la plataforma con respecto a la superficie media de la Tierra se utiliza para determinar la topografía de la superficie subyacente (imagen 66).

Imagen 65. LIDAR-Lite v3

Imagen 66. Topografía de Marte. Órbita de Marte con altímetro láser.

Los lidars más avanzados miden la intensidad recibida de la luz retrodispersada en función del tiempo de viaje (imagen 67). La intensidad de la señal proporciona información sobre el material que reflejó los fotones.

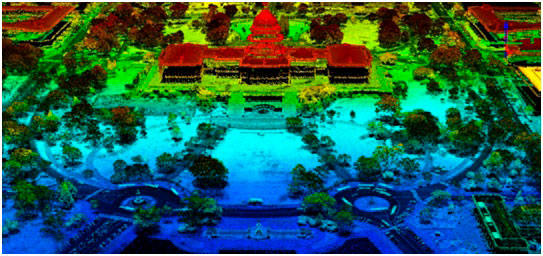

Lidar 3D del edificio del Capitolio de los Estados Unidos en Washington DC

Fuente: GIS Geography <https://gisgeography.com/lidar-light-detection-and-ranging/>

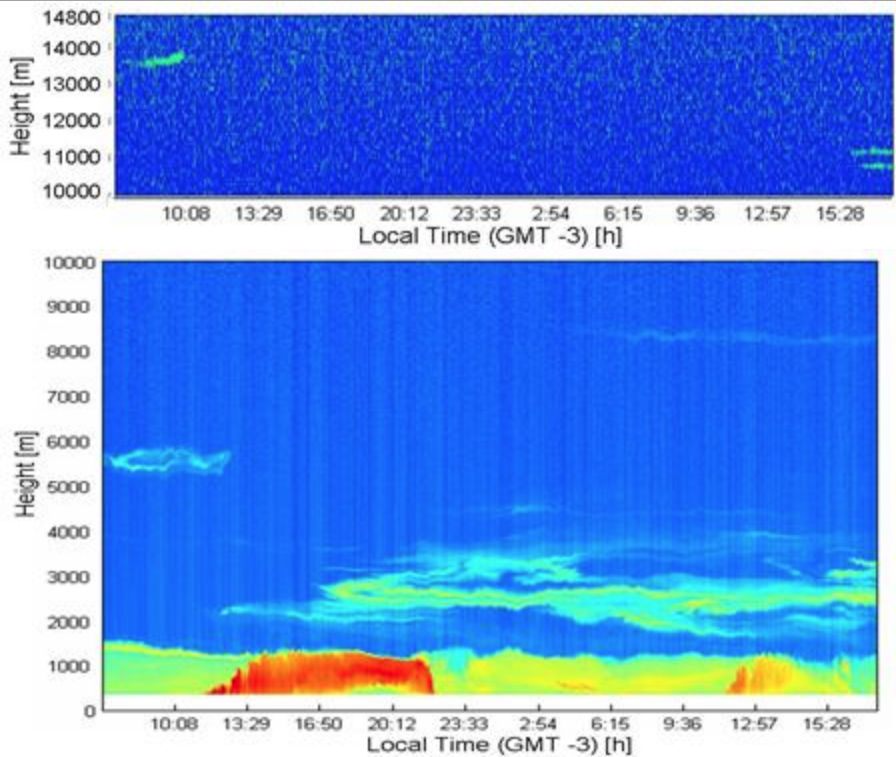

Estos sistemas lidar de retrodispersión se usan a menudo para aplicaciones de monitoreo atmosférico relacionadas con la detección y caracterización de diversos gases, aerosoles y partículas (imagen 68). Los métodos lidar se han adaptado recientemente para medir la altura de los árboles y la distribución vertical de las capas del dosel arbóreo con gran precisión (imagen 69) (CCPO, 2003; NASA, 2018).

Imagen de la primera medición lidar de plumas de cenizas volcánicas sobre la provincia de Buenos Aires durante la erupción del volcán Chaitén en mayo de 2008 (cenizas volcánicas a los 3, 5 y 14 km de altura)

Fuente: Imagen extraída de Pawelko et al. (2008) <https://lidar.com.ar/>

Detección lidar de altura de dosel y arquitectura de altímetro láser

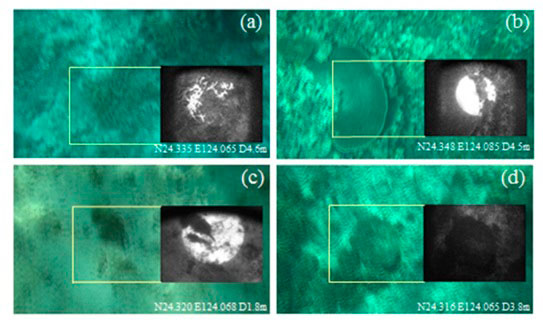

Los sistemas lidar también pueden realizar mediciones de fluorescencia. La fluorescencia se refiere al proceso en el que un material absorbe energía radiante en una longitud de onda y luego la emite en una longitud de onda diferente, sin convertir primero la energía absorbida en energía térmica. Las longitudes de onda en las que se producen la absorción y la emisión son específicas de moléculas particulares. Los datos de fluorescencia pueden identificar y cuantificar la cantidad de plancton y contaminantes en el ambiente marino. La fluorescencia de la hoja también puede ayudar a identificar especies de plantas (imagen 70).

Las muestras de las imágenes lidar de fluorescencia se superponen con imágenes de video grabadas simultáneamente. (a) Coral tipo rama; (b) coral de tipo tabla; (c) macroalgas sobre arena; (d) esqueleto de coral muerto. Las imágenes de fluorescencia grabadas por la cámara ICCD se muestran en monocromo. Las huellas láser se muestran como círculos centrados. Las partes blancas dentro de la huella del láser indican una fluorescencia intensa

Fuente: Sasano, Imasato,Yamano y Oguma (2016).

St. Paul's London LiDAR movie

Fuente: Andy Hudson-Smith. Disponible en: <https://www.youtube.com/watch?v=4vEIguZSF-4> [Consulta: 27 de junio 2006].

Resolución de los sensores satelitales

La radiación (emitida o reflejada) de la superficie terrestre es un fenómeno continuo presente en cuatro dimensiones (espacio, tiempo, longitud de onda y radiancia). Un sensor debe ser capaz de muestrear este continuo discretizándolo. Salvo en determinadas excepciones, se trabajará con ventanas atmosféricas y se seleccionará aquella combinación de regiones del espectro que mayor información puedan proporcionar sobre los fenómenos que se quieren estudiar. La forma en la que se lleva a cabo esta discretización determina los cuatro tipos de resolución con los que se trabaja en teledetección: resolución espacial (tamaño de píxel), resolución espectral (indica el número y anchura de las regiones del espectro para las cuales capta datos el sensor), resolución radiométrica (número de intervalos de intensidad que pueden captarse) y resolución temporal (tiempo que transcurre entre dos imágenes) (Alonso-Sarría, 2013).

Pérez Gutiérrez, C. y Muñoz Nieto, A. (eds.) (2006), Teledetección: nociones y aplicaciones, Ávila, pp. 6-9. Disponible en <https://mundocartogeo.files.wordpress.com/2015/03/teledeteccion-nocionesaplicaciones-2006publico.pdf>

Luego de ver el siguiente video reflexione sobre las posibilidades y problemáticas del uso de la teledetección en la agricultura de precisión en Argentina.

Alonso, F. (2006), “SIG y teledetección (SIGMUR).Tema 3: Plataformas, sensores y canales”, Universidad de Murcia, pp. 29-34. Disponible en <https://www.um.es/geograf/sigmur/teledet/tema03.pdf>

Resolución espacial

Define la capacidad del sistema para distinguir objetos en función de su tamaño. Es decir, la resolución espacial suele interpretarse como el tamaño del objeto más pequeño que puede ser distinguido en una imagen: el tamaño del píxel sobre el terreno. La resolución espacial dependerá de una serie de factores: a) la altura del sensor con respecto a la Tierra, b) el ángulo de visión, c) la velocidad de escaneado y d) las características ópticas del sensor (Pérez Gutiérrez y Muñoz Nieto, 2006).

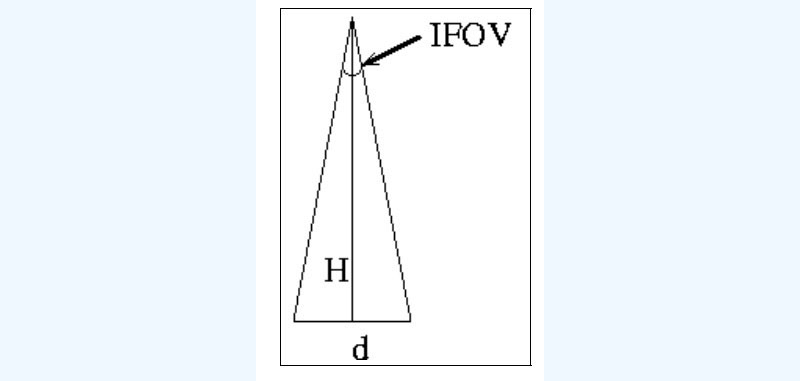

Como se señalaba anteriormente, la resolución espacial es el tamaño del píxel. En algunos casos se emplea el concepto de IFOV (campo instantáneo de visión), que se define como la sección angular (en radianes) observada en un momento determinado (imagen 71).

\[ d = 2Htan \left( \frac{IFOV}{2} \right) \]

donde d es el tamaño de píxel y H la distancia del sensor a la superficie terrestre.

Relación IFOV-tamaño de píxel

Fuente: Universidad de Murcia. <https://www.um.es/geograf/sigmur/teledet/tema03.pdf>

Actualmente, existe un amplio rango de resoluciones espaciales disponibles en los satélites (imagen 72). Meteosat y los satélites geoestacionarios ofrecen una resolución espacial de 5000 m como consecuencia de su cobertura a escala global de la superficie terrestre, los satélites de la serie NOAA-AVHRR tienen resoluciones que van entre 500 y 1100 m. Landsat TM tiene una resolución espacial de 30x30 m en las bandas 1, 2, 3, 4, 5 y 7 y de 120x120 m en la 6 (térmica). El sensor SPOT-HRV tiene una resolución de 10x10 m. El sensor Ikonos-1 tiene una resolución de 1 m.

Resolución espacial

Fuente: INEGI, México.

Es necesario tener en cuenta la relación entre la resolución espacialN y la escala espacial a la que ocurren los fenómenos que se quieren observar. Entre ambas tiene que darse una buena equivalencia (Pérez Gutiérrez y Muñoz Nieto, 2006).

No obstante, en algunas ocasiones resulta útil contar con un tamaño de píxel más grande, ya que con ello se reduce la variabilidad de categorías. La tabla siguiente recoge la resolución espacial de algunos sensores.

En muchas ocasiones se relaciona resolución espacial con calidad de las imágenes. No obstante, no tiene sentido tal relación, ya que cada sensor tiene la resolución óptima para los objetivos que se pretenden alcanzar. Por ejemplo, los satélites meteorológicos como Meteosat se utilizan para analizar fenómenos muy dinámicos, de ahí que necesiten una gran resolución temporal (30 minutos) y una imagen de gran tamaño (todo el planeta). Resultaría muy problemático multiplicar su resolución espacial.

Tabla 3. Resolución espacial de algunos sensores

|

Satélite |

Sensor |

Resolución espacial |

|

Quickbird |

|

0.61 m |

|

Ikonos |

|

1 m |

|

Orbview 3 |

|

1 m |

|

SPOT 5 |

|

2.5 m |

|

SPOT 3 |

HRV pan |

10 m |

|

Landsat 7 |

ETM + pan |

15 m |

|

Landsat 5 |

TM pan |

30 m |

|

MOSS |

VTIR |

900 m |

|

NOA |

AVHRR |

1100 m |

|

Meteosat |

VISSR |

5000 m |

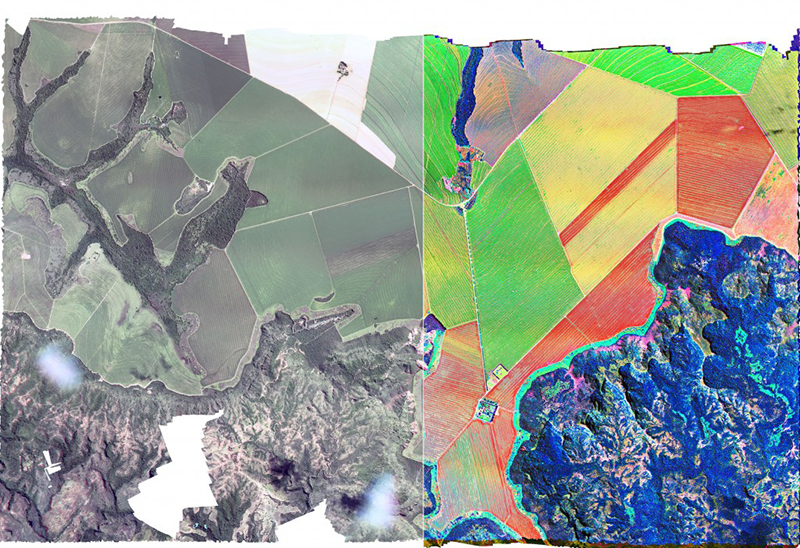

Resolución espectral

La resolución espectral indica el número de canales espectrales (y su ancho de banda) en los que el sensor puede captar radiación electromagnética (imagen 73). En principio, cuantas más bandas incluya un sensor más información podrá obtenerse, ya que cada banda constituye una variable para caracterizar la superficie captada. Por ejemplo, se obtiene más información al tener tres bandas en el visible (rojo, verde, azul) que con una sola banda (fotografía en blanco y negro). En relación con su tamaño, es preferible que estas bandas sean estrechas para que se incremente su capacidad discriminante. Si las bandas son demasiado anchas van a recoger valores promediados que encubrirán elementos de diferenciación. El número de bandas y su localización en el espectro dependerán de los objetivos que se pretendan cubrir con la puesta en funcionamiento del sensor.

Resolución espectral

Fuente: INEGI, México.

Los nuevos sensores, llamados también "espectrómetros" o "hiperespectrales", llegan a tener hasta 256 canales con un ancho de banda muy estrecho (unos pocos nm) para poder separar de forma precisa distintos objetos por su comportamiento espectral (imagen 74).

Las imágenes hiperespectrales permiten ver lo que nuestro ojo humano no ve. Esta cualidad tan especial las convierte en una herramienta muy eficaz para estudiar el cambio climático, detectar agentes contaminantes en aguas, controlar incendios forestales o analizar yacimientos geológicos (imagen 75). Son, además, imágenes de gran tamaño y dimensión, que ocupan mucho espacio de almacenaje (Martín Hernández, 2013).

Diferencia en el uso de imágenes multiespectrales e hiperespectrales en agricultura

Resolución temporal

La resolución temporal indicará el intervalo de tiempo entre cada imagen obtenida por la plataforma. Esta temporalidad es de media hora en el caso de los satélites geosíncronos y variable en el caso de los satélites heliosíncronos (imagen 76). En la actualidad, existen satélites de muy alta resolución espacial con sensores orientables, de forma que la zona sobre la que captan imágenes es relativamente independiente de la posición que ocupe el satélite, con lo que la resolución temporal pasa a ser algo más flexible. Normalmente, a mayor resolución espacial, menor resolución temporal y espectral. No obstante, el problema reside en que al aumentar la resolución se multiplica el volumen de datos que el sensor debe (pre)procesar y enviar a las estaciones en tierra. Por ello, el desarrollo de sensores de orientación modificable ha permitido compatibilizar alta resolución espacial y alta resolución temporal a costa de una toma de imágenes no sistemática (Pérez Gutiérrez y Muñoz Nieto, 2006).

Señalando algunos ejemplos, el ciclo de repetición de los Landsat-1, Landsat-2 y Landsat -3 era de 17 días. A partir del Landsat-4, en 1984, el ciclo de repetición se redujo a 15 días. SPOT tiene un ciclo de repetición de entre 3 y 26 días.

Resolución temporal

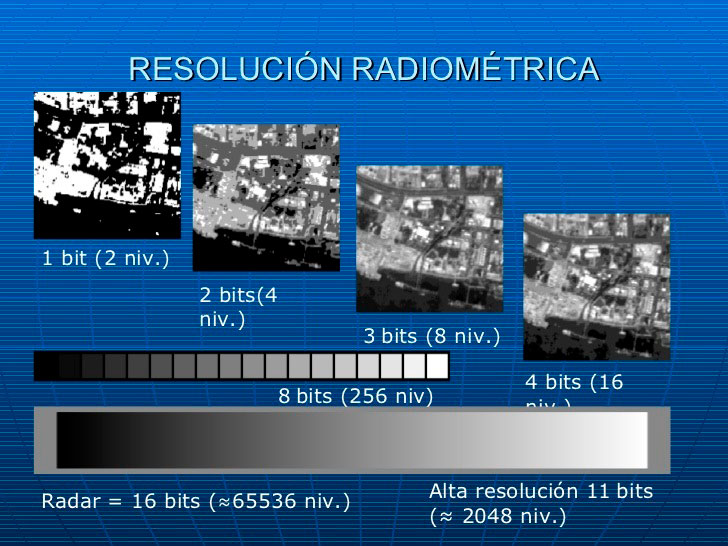

Resolución radiométrica

La resolución radiométrica se refiere a la sensibilidad del sensor, es decir, la capacidad de discriminar entre pequeñas variaciones en la radiación que capta. Se la llama a veces también "resolución dinámica" (imagen 77). Suele expresarse mediante el número de bits necesarios que se precisan para almacenar cada píxel. Por ejemplo, Landsat-TM utiliza 8 bits lo que da 28=256 niveles de energía (niveles digitales, ND) que pueden ser captados. Landsat MSS, por otro lado, tiene 26=64 niveles de energía en el canal 6. Cuanto mayor sea la precisión radiométrica mayor número de detalles podrán captarse en la imagen.

Soria, M. y Matar, M. (2016), “Nociones de teledetección” [en línea], pp. 47-55. Laboratorio de Procesamiento de Imágenes y SIG. Instituto de Investigaciones Mineras, Facultad de Ingeniería, Universidad Nacional de San Juan, San Juan. Disponible en <https://www.unsj.edu.ar/unsjVirtual/cartografiaaplicadaminas/wp-content/u...

Resolución espacial, espectral y temporal

Fuente: Ecogeo extensión <https://www.youtube.com/watch?v=dMlvNp8gUKo> publicado: 11/julio/2017.

Empresas dedicadas a la fabricación de equipos de tratamiento digital de imágenes

- DRAGON, Amherst, Estados Unidos

- ENVI, Boulder, Estados Unidos

- ERDAS, Atlanta, Estados Unidos

- ER-Mapper, West Perth, Australia

- ESRI, Nueva York, Estados Unidos

- IDRISI, Worcester, Estados Unidos

- ILWIS, Enschede, Holanda

- Intergraph, Cambridge, Reino Unido

- MultiSpec, Universidad de Purdue (dominio público)

- PCI, Ontario, Canadá

Fuente: extraído de “Lista de Teledetección”. Grupo de Trabajo Mercator de la EUIT Topográfica de la Universidad Politécnica de Madrid/ Laboratorio de Teledetección del INTA. <https://redgeomatica.rediris.es/teledeteccion/listatdt3.html>

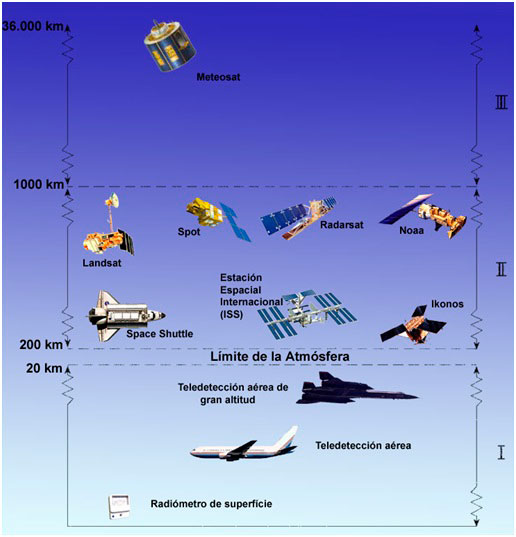

2.2.2. Plataformas

Las plataformas son las estructuras o vehículos en los que se insertan los instrumentos de detección remota. La plataforma en la que se aloja un sensor en particular determina una serie de características que pueden condicionar el uso de ese sensor específico. Estas características son: la distancia a la que se encuentra el sensor del objeto de interés, la periodicidad de adquisición de la imagen, el tiempo de adquisición de la imagen y la ubicación y el alcance de la cobertura (Pérez Martínez, 2011). Hay tres categorías amplias de plataformas de detección remota: terrestres, aéreas y satelitales (imagen 78).

Plataformas de teledetección

Existe una amplia variedad de plataformas terrestres para la teledetección. Algunas de las más comunes son los dispositivos de mano, trípodes, torres y grúas. Los instrumentos que se posicionan a la altura de la superficie terrestre a menudo se utilizan para medir la cantidad y la calidad de la luz que proviene del Sol o para la caracterización de objetos a corta distancia, por ejemplo, para estudiar las propiedades de una sola planta o un pequeño trozo de terreno. Los instrumentos de campo también se utilizan en gran medida para fines de investigaciónN. Este tipo de instrumento de teledetección remota es, a menudo, portátil o está colocado sobre un trípode u otro soporte similar (imagen 79). Las plataformas terrestres permanentes se usan normalmente para monitorear fenómenos atmosféricos, aunque también se utilizan para el monitoreo a largo plazo de las características terrestres (CCPO, 2003; Chuvieco, 1995).

Existen, asimismo, instrumentos de laboratorio que se utilizan casi exclusivamente para investigación, calibración de sensores y control de calidad. No obstante, es un trabajo imprescindible, ya que gran parte de lo que se aprende del trabajo de laboratorio se utiliza para comprender cómo se puede utilizar mejor la detección remota para identificar diferentes materiales o procesos. Esto contribuye al desarrollo de nuevos sensores que mejoran las tecnologías existentes (CCPO, 2003).

Instrumentos de teledetección terrestre

Las plataformas aerotransportadas fueron las únicas plataformas no terrestres para el trabajo temprano de detección remota durante aproximadamente un siglo (hasta el inicio de las plataformas satelitales). Las primeras imágenes aéreas se adquirieron con una cámara transportada por un globo en 1859. Los globos raramente se usan hoy en día porque no son muy estables y el curso del vuelo no siempre es predecible, aunque los globos pequeños que llevan sondas desechables todavía se usan para monitorear algunos efectos meteorológicos (CPPO, 2018).

En la actualidad, las plataformas de aerotransporteN más usadas son los aviones y los drones. Casi todo el espectro de aviones civiles y militares se utiliza para aplicaciones de detección remota. Cuando los requisitos de altitud y estabilidad de un sensor no son demasiado exigentes, se pueden utilizar aviones simples o drones como plataformas. Las aeronaves se dividen en tres categorías (baja, media y alta) según sus restricciones de altitud. En general, cuanto más alto puede volar un avión, más estable es su plataforma, pero, en consecuencia, más costoso de operar y mantener.

Las aeronaves de baja altitud suelen volar por debajo de altitudes donde se necesita oxígeno suplementario o presurización (12 500 pies sobre el nivel del mar). Son adecuadas para adquirir datos de alta resolución espacial limitados a un área relativamente pequeña. Esta clase de aeronave es bastante asequible y se puede encontrar en todo el mundo. Algunos de estos aviones están especialmente equipados para transportar instrumentos de sensores remotos en la parte inferior del avión, otras veces los instrumentos se cuelgan de la puerta utilizando montajes simples. Los helicópteros se usan generalmente para aplicaciones de baja altitud donde se requiere la capacidad de flotar. Tienen un costo bastante elevado y se usan solo cuando son imprescindibles. Los aviones ultraligeros tienen una velocidad máxima de 55 nudos y no llevan más de 15 litros de combustible. Estos aviones pequeños, a menudo portátiles, son asequibles y pueden despegar y aterrizar donde no pueden los aviones más grandes. Se limitan a volar en elevaciones más bajas y a velocidades lentas. También es de uso frecuente la aeronave de control remoto o dron. Las aeronaves controladas a distancia se utilizan a menudo para condiciones en las que puede ser demasiado peligroso volar y no se requiere demasiada estabilidad o altura.

Los aviones de altitud media tienen un límite de altitud inferior a 30 000 pies sobre el nivel del mar. A menudo, en altitudes más altas, hay menos turbulencia, por lo que la estabilidad es mejor. Esta clase de avión se usa cuando la estabilidad es un requisito imprescindible y cuando es necesario o deseable adquirir imágenes desde una distancia mayor que la disponible en aviones de baja altitud. Estos aviones pueden obtener una mayor cobertura de área con mayor rapidez que las plataformas de baja altitud.

Los aviones de gran altitud pueden volar a altitudes superiores a 30 000 pies sobre el nivel del mar. Generalmente funcionan con motores a reacción y se utilizan para tareas especializadas, como estudios atmosféricos, investigaciones para simular plataformas satelitales y otras aplicaciones donde se requiere una plataforma de gran altitud. Los aviones de gran altitud son buenos para adquirir una gran cobertura de área con resoluciones espaciales más bajas (CCPO, 2003; NASA, 2018).

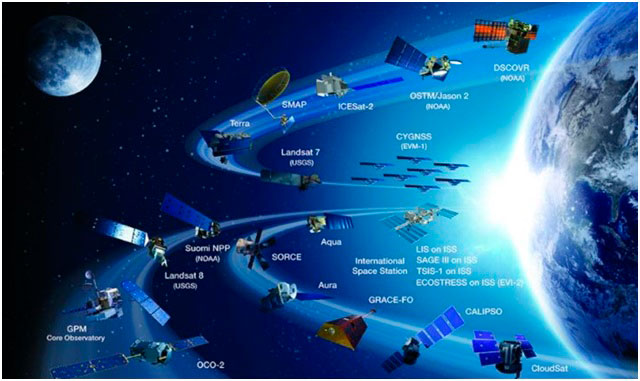

Finalmente, las plataformas satelitales son las plataformas más estables para la teledetección. El primer satélite de teledetección se lanzó en 1960 con fines de meteorología. En la actualidad, los últimos datos de la NASA y de la Online Satellite Calculations señalan que hay cerca de 3500 satélites artificiales en pleno funcionamiento (de comunicaciones y teledetección remota) (NASA, 2018).

Lea con atención la siguiente noticia:

Reflexione y conteste las siguientes preguntas:

- ¿Podemos conocer el número real de satélites puestos en órbita por cada país?, ¿por qué?

- ¿Cuáles serán los principales problemas de la puesta en órbita de cada vez más satélites alrededor de la Tierra?

- ¿A qué países afectarían, especialmente, futuras restricciones para colocar satélites en órbita?, ¿por qué?

- Investigando más allá de la noticia, ¿existe algún programa de las agencias espaciales de “limpiar” los viejos satélites en desuso, o los restos de colisiones y fragmentos?

La mayoría de los satélites de detección remota han sido diseñados para transmitir datos a estaciones receptoras terrestres ubicadas en todo el mundo. Para recibir datos directamente de un satélite, la estación receptora debe tener una línea de visión al satélite (en caso contrario puede ocasionar problemas potenciales de discontinuidad de los datos). Para solucionar este problema, los datos pueden almacenarse temporalmente a bordo del satélite y luego descargarse al adquirir contacto con la estación receptora. Otra alternativa es retransmitir datos a través de TDRSS (Sistema Satelital de Seguimiento y Retransmisión de Datos), una red de satélites de comunicaciones geoestacionarios desplegados con la intencionalidad de retransmitir datos de satélites a estaciones terrestres. La carga útil para los satélites de detección remota puede incluir sistemas fotográficos, sensores electro-ópticos, sistemas de microondas o lidar. Para las aplicaciones que se benefician de la cobertura simultánea de diferentes sensores, se puede incluir más de un sistema de detección en un solo satélite. Además de los sistemas de sensores remotos, a menudo hay dispositivos para grabar, preprocesar y transmitir los datos (CCPO, 2003; NASA, 2018).

Chuvieco, E. (1995), Fundamentos de Teledetección espacial, segunda edición, Rialp, Madrid, pp. 116-130.

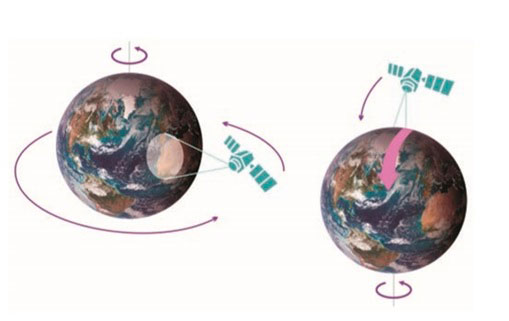

Características orbitales de las plataformas de teledetección

Un dato importante a tener en cuenta cuando hablamos de plataformas satelitales es la trayectoria que estos satélites describen alrededor de la Tierra: la órbita. Dicha órbita estará condicionada por las características y objetivos de los sensores de cada satélite, los principales factores determinantes son la altitud, la orientación y la rotación con respecto a la Tierra. Los satélites describen dos tipos principales de órbitas: las órbitas geoestacionarias (imagen 80, izquierda) y las órbitas cuasi polares (imagen 80, derecha).

Las órbitas geoestacionarias son aquellas que describen los satélites que están situados a grandes alturas y siempre ven la misma porción de superficie terrestre […] Su altura suele ser de 36.000 km y se mueven a una velocidad angular igual a la de la rotación de la Tierra, por lo que siempre permanecen en la misma posición relativa respecto a la superficie terrestre. Satélites meteorológicos como el Meteosat tienen este tipo de órbitas. (Labrador García, Évora Brondo y Arbelo Pérez, 2012: 15).

Órbita geoestacionaria (izquierda). Órbita cuasi polar (derecha)

Fuente: Labrador García, Évora Brondo y Arbelo Pérez (2012).

No obstante, la mayor parte de los satélites de teledetección son diseñados para describir una órbita de norte a sur que va a permitirles cubrir –en conjunción con la rotación de la Tierra (de oeste a este)– una mayor parte de la superficie terrestre durante un periodo de tiempo concreto. Estas órbitas se denominan "cuasi polares" debido a su inclinación relativa con respecto a una línea trazada entre los polos norte y sur (imagen 80, derecha). Es importante señalar que la mayor parte de los satélites de órbita cuasi polar son, además, heliosíncronos, es decir, cubren la misma área del mundo a una hora local fija del día: la hora solar localN.

En un latitud específica, la posición del Sol en el cielo, al igual que la posición del satélite que orbita, será similar en la misma estación del año. Este hecho posibilita condiciones de luz análogas en las imágenes adquiridas en una estación determinada a lo largo de una serie de frecuencias (diarias, mensuales, anuales). De este modo, es posible monitorizar cambios entre imágenes o realizar mosaicos superponiendo imágenes adyacentes, al no tener que ser corregidas por diferentes condiciones de iluminación.

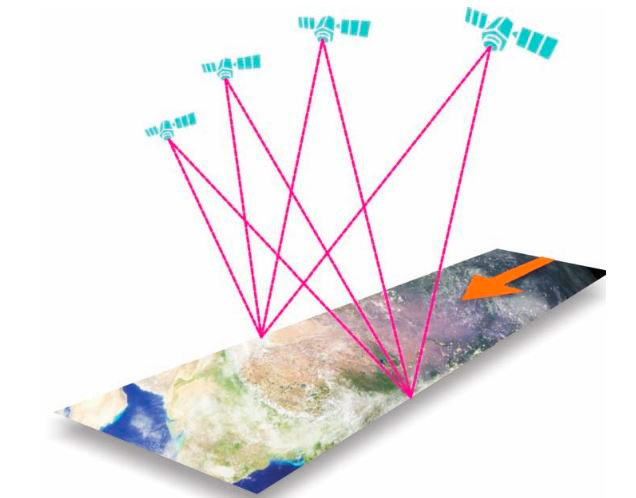

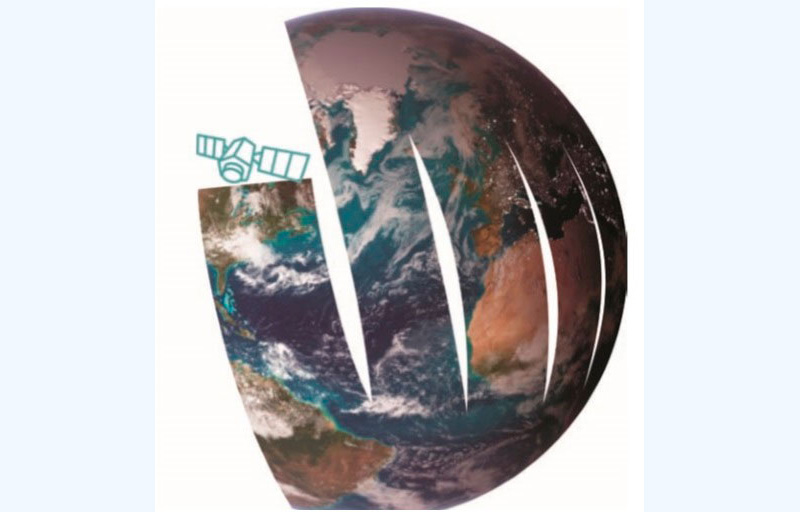

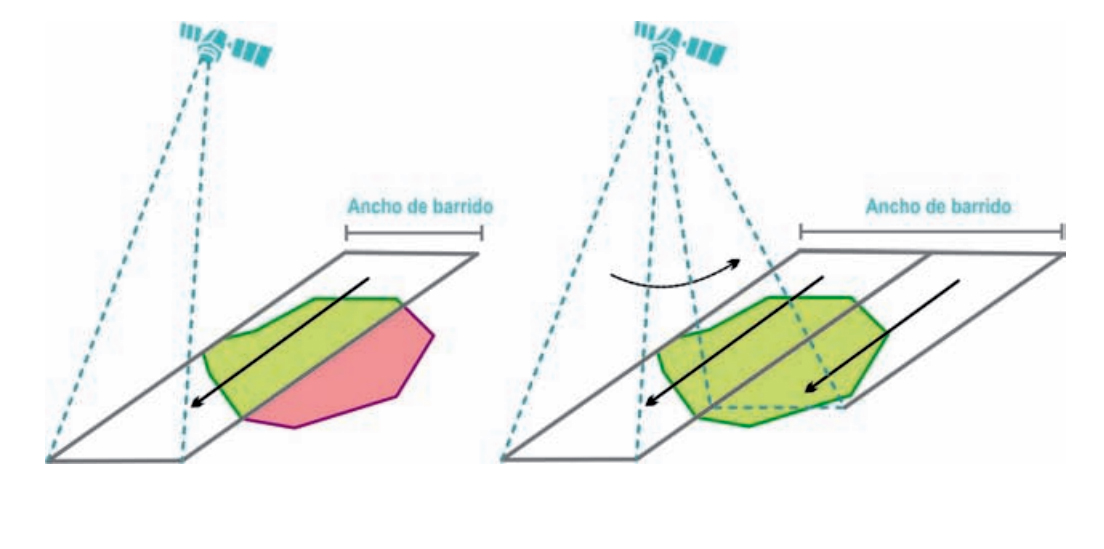

En su órbita alrededor de la Tierra, el satélite solo puede registrar información de una parte de la misma. Esta porción de la superficie terrestre de la que recoge información se denomina ancho de barrido (imagen 81). Este ancho de barrido es muy heterogéneo, puede variar desde decenas a cientos de kilómetros según el tipo de sensor y la altura del satélite. En muchos satélites esto va a determinar la capacidad para captar, en una sola pasada, un área concreta. Si el ancho del área a registrar es superior al ancho de barrido, la imagen no podrá ser captada en una sola toma y será necesario esperar a un segundo pase (Labrador García, Évora Brondo y Arbelo Pérez, 2012: 15).

Ancho de barrido

Fuente: Labrador García, Évora Brondo y Arbelo Pérez (2012).

Algunos de los satélites más actuales tienen la capacidad de reorientar en cualquier dirección (off-nadir) el sensor durante la toma de imágenes y añadir franjas adyacentes en una única pasada. De este modo, aumenta el ancho de barrido práctico del satélite y su capacidad de adquisición de imágenes (imagen 82).

Es necesario señalar que los satélites con órbita cuasi polar son capaces de tomar muchas más imágenes de altas latitudes que de las zonas ecuatoriales debido al incremento del solape en anchos de barridos adyacentes (superposición de ciertas partes de las imágenes tomadas), ya que las trayectorias orbitan cerca de los polos (Labrador García, Évora Brondo y Arbelo Pérez, 2012: 16).

Barrido simple (izquierda) frente a barrido múltiple (derecha) en una sola pasada del satélite

Fuente: Labrador García, Évora Brondo y Arbelo Pérez (2012).

Satélites (Landsat, SPOT, NOAA)

Existen más de 100 satélites de teledetección remota puestos en órbita y se planea seguir lanzando más en un futuro cercano. Aunque países como Estados Unidos, Rusia, China y regiones como Europa dominan el espacio (y la industria) satelital, cada vez son más los países que se suman a esta tecnología. En este apartado, profundizaremos, como ejemplo, en tres programas y plataformas satelitales por su importancia y alcance mundial en teledetección. Por un lado, las series Landsat y SPOT (Systèmé Probatoire d'Observation de la Terre) por su largo historial de recopilación continua de datos de la cobertura terrestre. Por otro, la serie de satélites NOAA (Administración Nacional Oceánica y Atmosférica) con sus AVHRR (Radiómetro avanzado de muy alta resolución), muy útiles para el monitoreo global de la vegetación, biosfera, atmósfera y océanos (NASA, 2018).

La serie de satélites Landsat ha proporcionado imágenes satelitales continuas de la Tierra desde julio de 1972 hasta el presente. Landsat fue el primer satélite lanzado con la intención principal de proporcionar datos continuos a largo plazo de las imágenes de los recursos de la Tierra. El programa fue inicialmente administrado por el gobierno de los Estados Unidos, se privatizó de 1985 a 1991 y volvió a ser del gobierno federal en 1992. Hasta la fecha, se han lanzado ocho satélites en esta serie, aunque el sexto nunca alcanzó la órbita. El último de la serie es el Landsat 8, puesto en órbita el 11 de febrero de 2013.

Landsat 8

Fuente: NASA.

Todos los satélites Landsat se colocaron en órbitas síncronas solares cuasi polares. Los primeros tres volaron a altitudes de aproximadamente 900 km con cobertura repetida en la misma área cada 18 días; para Landsat 4 y 5 la altitud orbital se redujo a 705 km y la cobertura de repetición fue cada 16 días. Landsat-5 se colocó 8 días fuera de fase con Landsat-4 para producir efectivamente la cobertura de repetición de 8 días. La cobertura de repetición frecuente es una característica útil para monitorear la vegetación a través del tiempo. El ancho de la franja del terreno (área total cubierta por una línea de exploración) adquirida por Landsat mientras vuela es de 185 km (NASA, 2018).

Los satélites Landsat siempre han transportado sensores pasivos capaces de registrar energía electromagnética en las longitudes de onda visibles e infrarrojas. Lanzado en 1972, Landsat-1 (fuera de servicio) fue originalmente llamado ERTS (Earth Resources Technology Satellite) y tenía dos sensores, el Return Beam Vidicon (RBV) y el Multispectral Scanner (MSS). Aunque el RBV estaba destinado a ser el sensor primario durante el tiempo de vida del satélite, el rendimiento y la utilidad del MSS demostraron ser superiores. El MSS es un escáner de 4 canales capaz de medir la energía reflejada en longitudes de onda que van desde 0.4 a 1.1 μm con una resolución espacial de 80 m. Los 4 canales incluían una banda verde, roja y 2 infrarrojas cercanas. Las bandas MSS se han referenciado históricamente como bandas 4-7, ya que los 3 canales del RBV se etiquetaron como bandas 1-3.

En 1975, el programa ERTS pasó a llamarse Landsat y se lanzó Landsat-2. Landsat-1 y 2 eran misiones idénticas, con sensores duplicados de RBV y MSS. Landsat-3 (lanzado en 1978, fuera de servicio) contenía un RBV modificado y un MSS con un canal infrarrojo térmico adicional que no funcionó. Landsat-4 y 5 (fuera de servicio) (lanzados en 1982 y 1984, respectivamente) llevaban el MSS y un nuevo sensor, el Mapeador Temático (TM). El escáner TM tiene 7 bandas espectrales que van de aproximadamente 0.4 a 2.4 μm. Los canales 1-5 y 7 tienen resoluciones espaciales de 30 m, mientras que el canal 6 difiere con una resolución espacial de 120 m. Landsat-6 fue un lanzamiento fallido. Landsat-7 (imagen 83) (operativo actualmente) tiene un sensor de Mapeo Temático Mejorado (ETM +), que incluye un canal adicional con una resolución espacial de 15 m. Se lanzó otro satélite para volar varios minutos por delante de Landsat-7. Este satélite llevaba un instrumento de teledetección remota de nueva generación llamado Advanced Land Imager (ALI). La calidad de la imagen ALI se evalúa utilizando imágenes ETM +. El Landsat -8 (imagen 83) transporta dos instrumentos OLI y TIRS (Operational Land Imager y Thermal Infrared Sensor, respectivamente). El sensor OLI provee acceso a nueve bandas espectrales que cubren el espectro desde los 0.433 μm a los 1.390 μm, mientras que TIRS registra de 10.30 μm a 12.50 μm. Estados Unidos planea el lanzamiento del nuevo Landsat-9 para diciembre de 2020 (CCPO, 2003; NASA, 2018).

El programa de satélites de observación terrestre SPOT (Systèmé Probatoire d'Observation de la Terre) fue concebido y diseñado por el CNES francés (Centro Nacional de Estudios Espaciales), con participación belga y sueca poco después de su creación. Al igual que el programa Landsat, la serie SPOT tiene como objetivo proporcionar continuidad de datos a largo plazo. SPOT-1, 2 y 3 (fuera de servicio) se lanzaron en 1986, 1990 y 1993, respectivamente. Estos tres primeros satélites tenían las mismas órbitas y sensores. Fueron colocados en órbitas solares síncronas, cercanas a polares, a 832 km sobre la Tierra. La cobertura de repetición (que pasa por el mismo lugar) tenía un ciclo de 26 días.

SPOT-7

Fuente: AIRBUS Defence & Space.

La carga útil del sensor consistía en dos sistemas idénticos de imágenes de cámara de empuje HRV (alta resolución visible). Cada HRV fue diseñado para funcionar en cualquiera de los dos modos: 1) un modo pancromático con resolución espacial de 10 m, o 2) un modo multiespectral con resolución espacial de 20 m.

Una característica interesante de la HRV es que se puede apuntar para que mire hacia un lado (lo que se conoce como observación fuera del nadir). Esto proporciona la capacidad de adquirir imágenes de áreas que no están directamente debajo del satélite (aumentando efectivamente la cobertura de repetición si se desea) y de obtener imágenes estereoscópicas, útiles en el mapeo de terrenos y otras aplicaciones. En un ángulo de visión del nadir, el ancho de la franja del terreno (ancho total del terreno adquirido por la matriz del detector) para cada HRV individual es de 60 km. Cuando apunta hacia fuera del nadir, la franja aumenta. Los dos HRV juntos pueden orientarse para adquirir campos de imagen adyacentes en el nadir, con una franja total combinada de 117 km y 3 km de superposición.

SPOT-4 (en funcionamiento) se lanzó el 24 de marzo de 1998. Los sensores de 2 HRVIR (alta resolución visible e infrarroja, anteriormente HRV) tienen un canal espectral adicional en el infrarrojo medio (1.58-1.75 µm), útil para mejorar el monitoreo de la vegetación y la discriminación de minerales. Además lleva un nuevo instrumento con un amplio campo de visión diseñado específicamente para monitorear la vegetación. El VMI (Instrumento de Monitoreo de Vegetación) tiene una resolución espacial de 1 km y un ancho de franja de 2000 km, lo que proporciona cobertura mundial todos los días. Utiliza las mismas bandas espectrales que el HRVIR, con una banda espectral adicional (0.43-0.47 µm) para aplicaciones oceanográficas.

SPOT-5 fue lanzado en el 2002, diseñado en sinergia con Helios-2. Posee un instrumento ARG (Alta Resolución Geométrica) cuya innovación es la introducción del Súper-Modo que permite la creación de una imagen con 2.5 m de resolución a partir de dos imágenes de 5 m adquiridas simultáneamente con un semi-píxel de desfase. Su combinación se realiza mediante técnicas avanzadas de tratamiento y restauración de imágenes. Resolución de las imágenes producidas: 2.5 m en súper-modo pancromático (0.48-0.71 µm), 5 m en pancromático (0.48-0.71 µm), 10 m multiespectral. Banda 1: verde (0.50-0.59 µm), banda 2: rojo (0.61-0.68 µm), banda 3: infrarrojo cercano (0,78 - 0,89 µm), banda 4: infrarrojo medio (IRM) (1.58-1.75 µm) a 20 m. Posee capacidades de adquisición de pares estereoscópicos mejorados gracias al instrumento ARE (Alta Resolución Estereoscópica). Incorpora Vegetation-2, sucesor del Vegetation-1 que llevaba a bordo el SPOT-4.

El SPOT-6, lanzado en 2012, y el SPOT-7 (imagen 84), lanzado en 2014, satélites idénticos, han sido diseñados para garantizar la continuidad de la disponibilidad de los datos de alta resolución y un campo amplio de la superficie terrestre hasta 2024. Su arquitectura se compone de un instrumento óptico sobre el eje central, un sensor estelar con tres cabezales, un giroscopio de fibra óptica (FOG) y cuatro ruedas de reacción giroscópicas (Control Moment Gyroscopes). Estarán en fase sobre la misma órbita que los satélites Pléiades 1 y 2, a 694 km de altitud. Resolución de las imágenes producidas: pancromático: 1.5 m, color: 1.5 m, multiespectral: 6 m. Bandas espectrales, adquisiciones simultáneas pancromáticas y multiespectrales en las frecuencias siguientes: pancromático (45-745 nm), banda azul (455-525 nm), banda verde (530-590 nm), banda roja (625-695 nm), banda infrarrojo cercano (760-890 nm). Extensión: 60 km sobre 60 km. Programación reactiva: 6 planes de programación al día para cada satélite. Capacidad de adquisición: 3 millones de kilómetros cuadrados al día.

Los satélites de la serie NOAA (Administración Nacional Oceánica y Atmosférica) son plataformas meteorológicas diseñadas para ayudar en la predicción y monitoreo del clima. Los sensores a bordo de satélites meteorológicos, generalmente, tienen una resolución espacial muy baja en comparación con los sensores que estudian específicamente las características de la Tierra; sin embargo, su resolución temporal es alta y la cobertura de área es grande, obteniendo información global con mucha frecuencia.

Ilustración del satélite NOAA GOES-16

Los satélites NOAA se integran dentro del Programa POES (Polar Operational Environmental Satellite), desarrollado por la NASA junto con la agencia NOAA, Francia y el Reino Unido. Este programa mantiene, al menos, dos satélites orbitando simultáneamente alrededor de la Tierra. Uno de ellos cruza el Ecuador temprano en la mañana y el otro lo hace al atardecer (hora local). Por convenio, los satélites pares cubren las órbitas diurnas y los impares las nocturnas. De esta manera, hay una cobertura continua de la superficie terrestre. El primer satélite puesto en órbita de este programa fue el TIROS-N (Television Infrared Observation Satellite-Next Generation), lanzado en octubre de 1978. Fue el prototipo de una serie de cuatro generaciones de satélites operacionales. Por primera vez incluyó un instrumento AVHRR (Advanced Very High Resolution Radiometer), que proporciona información radiométrica en las zonas visible e infrarroja del espectro (Ministerio de Defensa, España, 2007).

A partir de 1978 se han puesto en órbita otros satélites del programa, denominados con una letra antes del lanzamiento y un número después. Así, por ejemplo, el NOAA-J, tras alcanzar su órbita pasó a llamarse NOAA-14; el NOAA-K, lanzado en 1998 cambió su nombre a NOAA-15. Tras el NOAA-15, se inició una nueva serie de satélites con importantes mejoras tecnológicas. Esta serie, llamada KLM, diseñó satélites como el NOAA-L y el NOAA-M, que incluyen instrumentos de microondas para trabajar en zonas de nubosidad. Los satélites NOAA-17/NOAA-M y NOAA-18/NOAA-N fueron lanzados en 2002 y 2005, respectivamente. El satélite NOAA-19 (lanzado en 2009) designado NOAA-N’ antes de su lanzamiento, es el último de la serie de satélites meteorológicos POES (Ministerio de Defensa de España, 2007; NOAA, 2018).

Otros importantes satélites puestos en órbita por el programa NOAA (fuera del programa POES) son: NOAA GOES-S, NOAA GOES-16/GOES East (imagen 85), Jason-3, DSCOVR y Sistema de Satélite Polar Conjunto (NOPS).

El satélite ambiental geoestacionario operacional, GOES-RSeries, es la flota de satélites meteorológicos geoestacionarios más avanzados de Estados Unidos. Esta serie mejora significativamente la teledetección y observación de fenómenos ambientales que afectan directamente la seguridad pública y a la propiedad privada. Los satélites proporcionan imágenes avanzadas con resolución espacial incrementada y cobertura más rápida para pronósticos más precisos, mapeo en tiempo real de la actividad de los rayos y monitoreo mejorado de la actividad solar y del clima espacial. La serie GOES-R es un programa de cuatro satélites (GOES-R / S / T / U) cuya misión es ampliar la disponibilidad del sistema operativo de satélites GOES hasta el 2036 (NOAA, 2018).

El satélite Jason-3, lanzado en 2016, es el último de una serie de satélites que miden la altura de la superficie del océano global, controla la tasa de aumento del nivel del mar y, junto a su predecesor, Jason-2, ayuda al Servicio Nacional de Meteorología de NOAA a predecir con mayor precisión la fuerza de los ciclones tropicales que amenazan las costas de Estados Unidos. Jason-3 está volando en una órbita baja, a 830 millas sobre la Tierra. Su altímetro de radar controla el 95% de los océanos libres de hielo del mundo cada 10 días. Complementariamente, los datos de Jason-3 se están utilizando para otras aplicaciones científicas, comerciales y operativas que incluyen: modelado de la altura de las olas del océano para operadores de embarcaciones comerciales; previsión de corrientes para envíos comerciales y enrutamiento de buques; pronósticos costeros para responder a los desafíos ambientales, incluidos los derrames de petróleo y la proliferación de algas nocivas; modelación costera, que es crucial para la investigación de mamíferos marinos y arrecifes de coral; y pronóstico de El Niño y La Niña. Jason-3 es una misión colaborativa internacional en la que NOAA se asocia con el Centro Nacional de Estudios Espaciales (CNES, Francia), la Organización Europea para la Explotación de Satélites Meteorológicos (Eumetsat) y la Administración Nacional de Aeronáutica y del Espacio (NASA) (NOAA, 2018).

El Deep Space Climate Observatory (DSCOVR), lanzado en 2015, monitorea el viento solar en tiempo real, imprescindible para dar seguimiento y gestionar con precisión las alertas y pronósticos de clima espacial de NOAA. El satélite DSCOVR sucederá al Advanced Composition Explore (ACE) de la NASA en el apoyo a las alertas y advertencias de viento solar desde la órbita L1, el punto de gravedad neutral entre la Tierra y el Sol. Desde esta posición, el DSCOVR podrá proporcionar un tiempo de advertencia de 15 a 60 minutos antes de que la oleada de partículas y el campo magnético –conocida como "eyección de masa coronal" (o CME)–, asociada con una tormenta geomagnética, llegue a la Tierra. Los datos de DSCOVR también se utilizarán para mejorar las predicciones de ubicaciones de impacto de tormentas geomagnéticas (NOAA, 2018).

Deep Space Climate Observatory (DSCOVR)

<https://www.nesdis.noaa.gov/content/dscovr-deep-space-climate-observatory>

El Sistema de Satélite Polar Conjunto (NOPS) de NOAA proporciona observaciones globales que sirven como eje a los pronósticos a corto y largo plazo, por ejemplo, en la predicción de eventos climáticos severos. Los cinco satélites programados en la flota son el satélite JPSS-1 o NOAA-20, Suomi NPP, JPSS-2, JPSS-3 y JPSS-4. Cada satélite transporta cinco instrumentos de vanguardia, entre ellos el Advanced Technology Microwave Sounder (ATMS), Cross-Track Infrared Sounder (CrIS), Radiometer Visible Infrared Imaging Visible Suite (VIIRS), Ozone Mapping y Profiler Suite (OMPS) y un instrumento para medir el presupuesto energético de la Tierra. Los satélites JPSS rodean la Tierra de polo a polo y cruzan el ecuador unas 14 veces al día en la órbita de la tarde para proporcionar una cobertura global completa dos veces al día. Más allá de la previsión, los satélites JPSS también desempeñan un papel fundamental en la detección y monitoreo de peligros ambientales, como sequías, incendios forestales, mala calidad del aire y aguas costeras perjudiciales, observaciones que proporcionarán de manera continua hasta el 2038.

NOAA trabaja en asociación con la NASA en todas las misiones JPSS, asegurando una serie continua de datos meteorológicos globales. Los satélites JPSS descargan sus datos a receptores terrestres a medida que pasan sobre estaciones en el Ártico y la Antártida cada 50 minutos. Suomi NPP descarga a una estación en Svalbard, Noruega, cerca del Polo Norte. JPSS-1 se pondrá en contacto con la estación de Svalbard y la estación de McMurdo, en la Antártida, cerca del Polo Sur (NOAA, 2018).

NASA's Earth Science Division, Operating Missions

Fuente: NASA.

Reflexione y conteste las siguientes preguntas:

En las técnicas de exploración de imágenes, ¿cómo se relacionan las propiedades de IFOV y el tiempo de permanencia entre sí y con la resolución tanto radiométrica como espectral?

Se ha obtenido una fotografía aérea, pero no hay información sobre la escala en la foto. ¿Es posible calcular la escala?

¿Podría considerarse una imagen aérea (fotografía o fotografía digital) como una especie de mapa? Justifique su respuesta.

Un camino mide 1 km de largo, pero en la fotografía aérea cubre solo 4 cm. ¿Cuál es la escala de la fotografía?

Nota aclaratoria: cuando en esta imagen se mide la distancia entre dos intersecciones de carreteras con un dispositivo de medición, resulta ser de 5 cm. En un mapa topográfico de 1: 24000, la distancia entre las mismas dos intersecciones de carreteras es de 2 cm.

2.3. Práctica 2. Aproximación a las imágenes satélite y a los programas de tratamiento de imagen satelital: la plataforma Land Viewer

Vea el siguiente video de aproximación al visor Land Viewer:

Acceda a Land Viewer en línea a través del siguiente link y siga el itinerario de información que se ofrece al usuario/a al inicio. Regístrese para poder empezar a utilizar la herramienta.

Tras familiarizarse con el visor, localice Balcarce, seleccione una imagen satelital entre las posibles. Escoja a través de las opciones una imagen sin nubes del periodo 01-01-2000 y el 01-02-2000. Genere una composición RGB de manera manual introduciendo cada banda por su canal de color y visualice de forma inmediata la composición RGB a falso color para observar diferentes cultivos. Descargue la imagen y archívela en una carpeta que se llame “Imágenes Argentina”. Realice un ejercicio interpretativo de lo observado.

Realice el mismo procedimiento del punto 3 para el periodo 01-01-2017 y el 01-02-2017.

Compare las dos imágenes, haga un ejercicio interpretativo e identifique los cambios más relevantes entre ambas imágenes.